關註公號回覆E-NVMe-oF關鍵字獲取白皮書

NVMe似乎成了儲存玩家的比爭之地,尤其在快閃記憶體領域,從FlashArray//X和Dorado NVMe儲存面世以來,其他主流儲存廠商都紛紛加入NVMe行列。

-

IBM FlashSystem 9110/9150

-

HPE Nimble AF Series

-

Dell EMC PowerMAX

-

NetApp AFF A800(今天不談)

通常情況下,上述產品的實現是將NVMe驅動新增到儲存後端,前端主機介面還是保持SCSI協議連結,但NetApp E-Series採取了另一種獨特的方法,從主機到EF570 /E5700的前端採用NVMe-oF (InfiniBand)網路,而後端仍然是基於SCSI的SAS驅動器,並非NVMe。

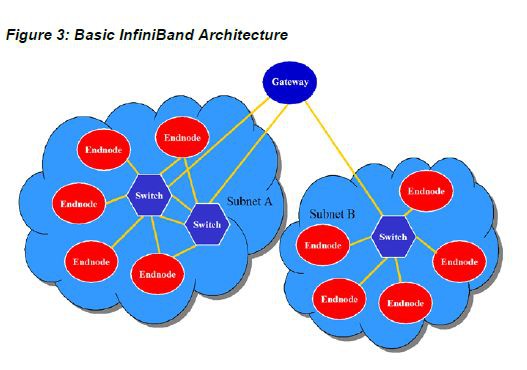

首先,我們來看下,什麼是InfiniBand架構,以及其主要元素是什麼?

InfiniBand網路的基本組成部分是: 主機通道配接器(HCA)、交換機、子網經理(SM)、閘道器等。

每個終端節點必須有一個主機通道配接器來設定和維護與主機裝置的連結。交換機包含多個InfiniBand埠,將資料包從一個埠轉發到另一個埠,以在子網中繼續傳輸資料包。

路由器用於將包從一個子網轉發到另一個子網(如果必要的話)。子網管理是透過軟體定義的網路來處理的,它控制網路的物理元素,並透過開放的、行業標準的介面引入流量工程特性。

什麼是主機通道配接器(HCA)?

主機通道配接器(HCA)是一種介面卡或控制器,它連線著InfiniBand導線和主機系統匯流排。每個終端節點都必須有一個HCA,它設定和維護主機裝置和網路上其他物體之間的連結。

HCA提供到其他裝置的埠連線。HCA可以連線到另一個HCA、標的裝置或交換機。

什麼是交換機? 在InfiniBand中如何工作?

交換機用於物理連線網路中的裝置,並將傳入的資料流量轉發到目的地。交換機有多個埠,可以透過電纜將資料處理和轉發到特定裝置,從而控制網路內的流量。

在InfiniBand網路中,交換機是InfiniBand結構的一個關鍵部分。實際上,InfiniBand被稱為“交換結構”或“基於交換的互連”,因為當流量被轉發時,就有一個從一個埠到另一個埠的邏輯連線,類似於老式的電話交換機。隨著更多的交換機被新增到系統中,裝置之間可能有更多的路徑。

什麼是子網管理器(SM)?

子網管理器(SM)是一個軟體物體,配置其本地子網並確保其執行。它在每個端點之間設定主路徑和次要路徑,以便預先程式設計流轉發決策並以最少的時間傳遞資料。子網中必須至少有一個SM,以便管理所有的交換機和路由器設定,併在鏈路斷開或出現新鏈路時重新配置子網。SM可以駐留在子網中的任何裝置上。

子網中的所有裝置必須包含專用子網管理代理(SMA), SM使用它與各種InfiniBand元件通訊。

一個子網中可以有多個SMs,只要在任何時刻只有一個是活動的。非活動SMs(稱為備用子網管理器)保留活動SM的轉發資訊的副本,並驗證活動SM是可操作的。如果活動SM發生故障,備用SM將接管其職責,以確保整個結構繼續執行。

軟體定義網路(SDN)已經成為子網管理的主要手段,它不僅控制網路裝置和它們之間的資料流量,而且增加了網路的靈活性和可伸縮性。

在InfiniBand網路中路由器是必需的嗎?

路由器用於在不同的計算機網路之間裝置連線。當資料到達路由器時,它讀取資料包中的地址資訊並確定最終目的地。

在乙太網網路中,由於泛洪機制和生成樹,大型子網的效率不高。因此,需要一個路由器來連線各種較小的子網。

這些問題在InfiniBand中不存在,在InfiniBand中,多達40,000個節點的大型子網可以高效執行。沒有必要劃分更小的子網,所以路由器不是必需的。

然而,隨著對資料中心的需求不斷增長,如果需要超過40000個節點的子網,就可以使用InfiniBand路由器技術,如Mellanox的IBTM交換機。

什麼是閘道器? 它如何在InfiniBand網路中工作?

閘道器是子網中的裝置,充當兩個協議之間的橋梁。例如,它允許InfiniBand叢集訪問乙太網網路或儲存介面。它允許公司實現一個Infini Band網路,透過有一個專用介面連線到執行他協議上的現有遺留裝置上。Virtual Protocol Interconnect (VPI)是Mellanox的一個技術,允許HCA或交換機中的任何埠執行InfiniBand或乙太網協議,並根據需要在兩個協議之間進行切換。

談談NVMe和VNMe over Fabric

關於NVMe大家應有所瞭解,NVMe已成為PCIe SSD的行業標準介面,具有簡化的協議和命令集,每個I/O的時鐘週期更少。NVMe支援最多64K佇列和每個佇列最多64K命令,這使得它比現有的基於SCSI的協議(如SAS和SATA)更高效。

NVMe-oF的引入使其更具有可伸縮性,同時仍然得益於低延遲和小開銷。NVMexpress.org規範概述了對VNMe的支援——NVMe-oF over Ethernet、RDMA和光纖通道(FC)。

相比SCSI,NVMe(NVMe-oF)可以支援更低的延遲I/O,不僅是因為裝置速度更快,還因為一些固有的優勢在Linux主機作業系統驅動程式棧(如上圖)。因此,I/O花費更少的總時間從應用程式的儲存,從而減少響應時間。

開篇提到,EF570/E5700儲存系統,從主機到的陣列前端採用NVMe-oF (InfiniBand)網路,而後端仍然是基於SCSI的SAS驅動器(EF 570 SAS SSD)。

NetApp EF570 全快閃記憶體專為混合工作負載環境(包括大資料分析、技術計算、影片監控和備份與恢復)設計,在微秒內提供超過1M的持續IOPS。EF570還是第一個支援包括32Gb光纖通道、25Gb iSCSI、100Gb InfiniBand、12Gb SAS和100Gb NVMe over InfiniBand的多種高速主機介面的陣列,保護儲存現有網路的投資。

如上圖所知,E/EF系列對第三方產品的相容性情況和支援元件,描述如下:

-

作業系統: SLES12 SP3, RHEL 7.4

-

HCAs: Mellanox FDR和EDR HCAs

-

交換機: Mellanox FDR和EDR InfiniBand交換機

-

拓撲結構: 交換和直接連線網路

那麼,為什麼NetApp要基於InfiniBand實現NVMe-oF的?主要原因如下:

-

InfiniBand內建了RDMA。

-

E-Series 已經支援其他的基於InfiniBand (SCSI based)的協議:例如iSCSI Extensions for RDMA (iSER)和SCSI RDMA Protocol (SRP)。

-

在EF570/E5700的相同硬體上可以執行iSER或SRP,以及NVMe-oF(但不是同時執行)。

-

以上三種協議都可以在同一種網路上共存,甚至可以在相同的InfiniBand主機通道配接器(HCA)埠上共存。這允許使用現有執行iSER和/或SRP的客戶,執行EF570/E5700的NVMe-oF連線到同一個網路。

-

網路中的所有InfiniBand元件(NetApp EF570/ E5700儲存、交換機、HCAs)都可以根據需要協商降低速度(如增強資料速率EDR 100Gbps、FDR 56Gbps、 QDR 40Gbps),這使得現網速度較低的遺留裝置變得很容易被支援。

NVMe-oF(InfiniBand),iSER,SRP這三種協議都可以在相同的網路結構上共存,甚至可以在主機端相同的InfiniBand HCA埠上共存。這就允許使用現有執行iSER/SRP的客戶將與執行NVMe-oF的EF570/E5700連線到同一種網路上(關註公號,回覆E-NVMe-oF關鍵字,獲取白皮書)。

本號涉及技術和總結(20+本)

可識別小程式獲取電子書詳細資訊

推薦閱讀:

溫馨提示:

請搜尋“ICT_Architect”或“掃一掃”二維碼關註公眾號,點選原文連結獲閱讀原文瞭解更多。

求知若渴, 虛心若愚

知識星球

知識星球