論文連結

https://www.paperweekly.site/papers/2769

原始碼連結

https://github.com/rainarch/DSNER

@figo 推薦

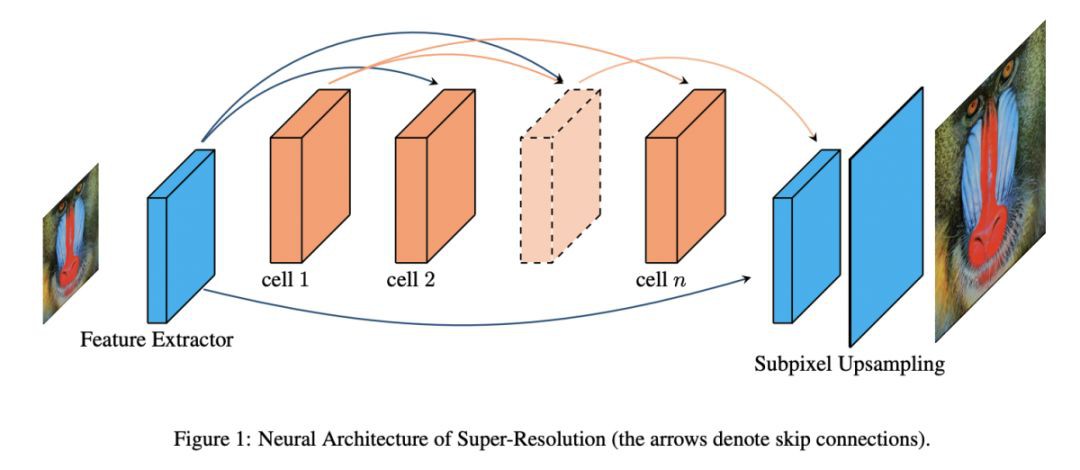

#Super-Resolution

本文出自小米原班人馬(上一篇是 MoreMNAS:https://www.paperweekly.site/papers/2740),屬於目前很火的 AutoML Neural Architecture Search。

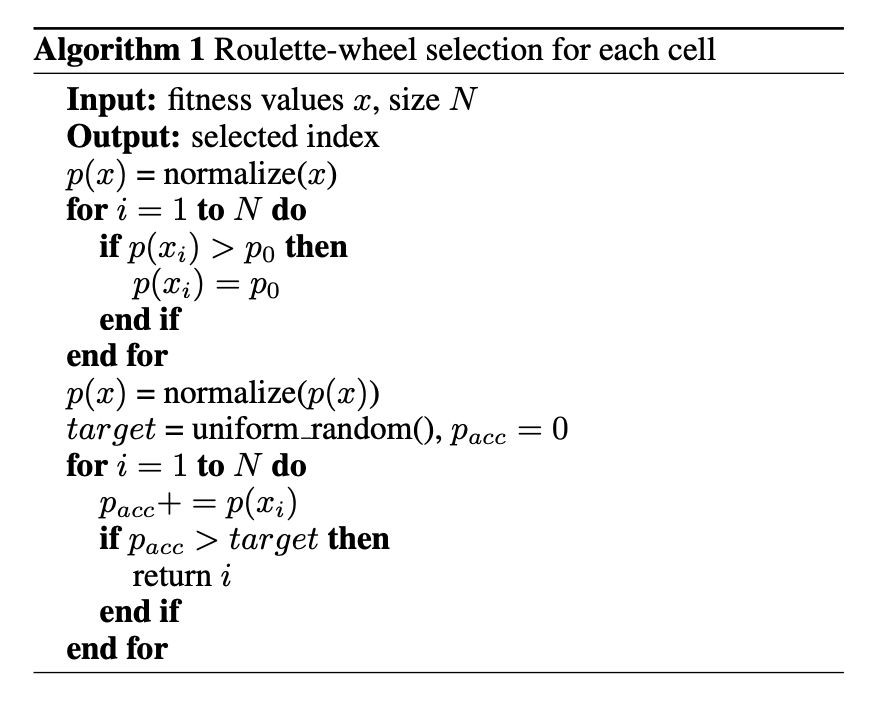

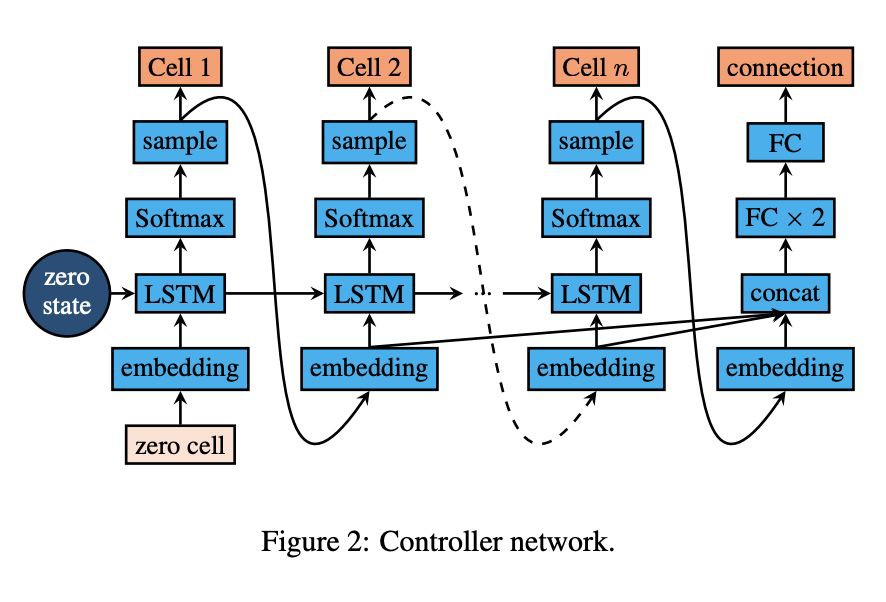

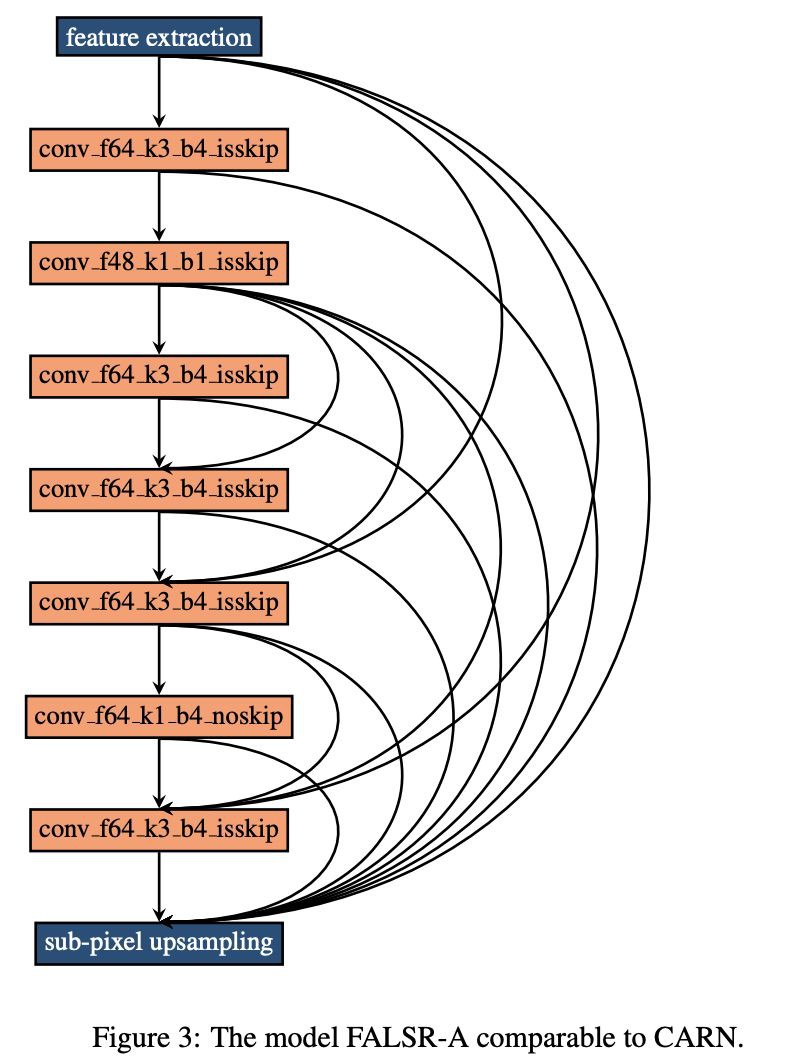

論文基於彈性搜尋(宏觀+微觀)在超解析度問題上取得了令人震驚的結果。在相當的 FLOPS 下生成了多個模型,結果完勝 ECCV 2018 明星模型 CARNM(乘加數引數數量少,PNSR/SSIM 指標高,文中稱 dominate),這應該是截止至 2018 年可比 FLOPS 約束下的 SOTA(涵蓋 ICCV 2017 和 CVPR 2018)。而達到這樣的效果,論文基於一臺 V100 用了不到 3 天時間。

此外,論文還給出了幾個前向模型。要知道上一篇論文中他們初步結果是擊敗 CVPR 2016,才半個月時間就提升這麼大,這也進一步驗證了 AutoML NAS 技術的強大和可怕。需要指出的是,該項技術具有一定的普適性,理論上可以應用於任何監督學習,值得關註和學習。

論文連結

https://www.paperweekly.site/papers/2786

原始碼連結

https://github.com/falsr/FALSR

@paperweekly 推薦

#Person Re-identification

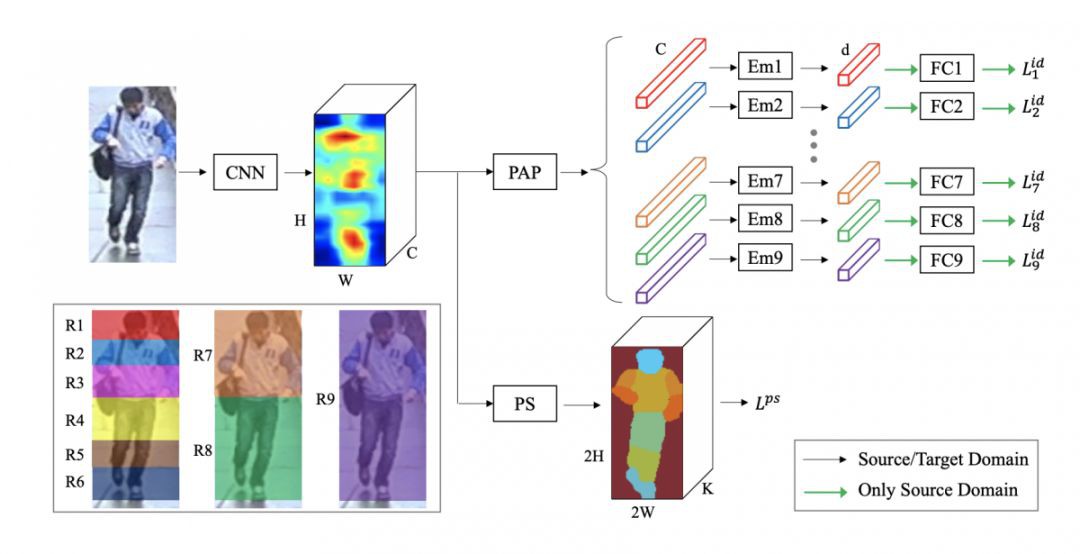

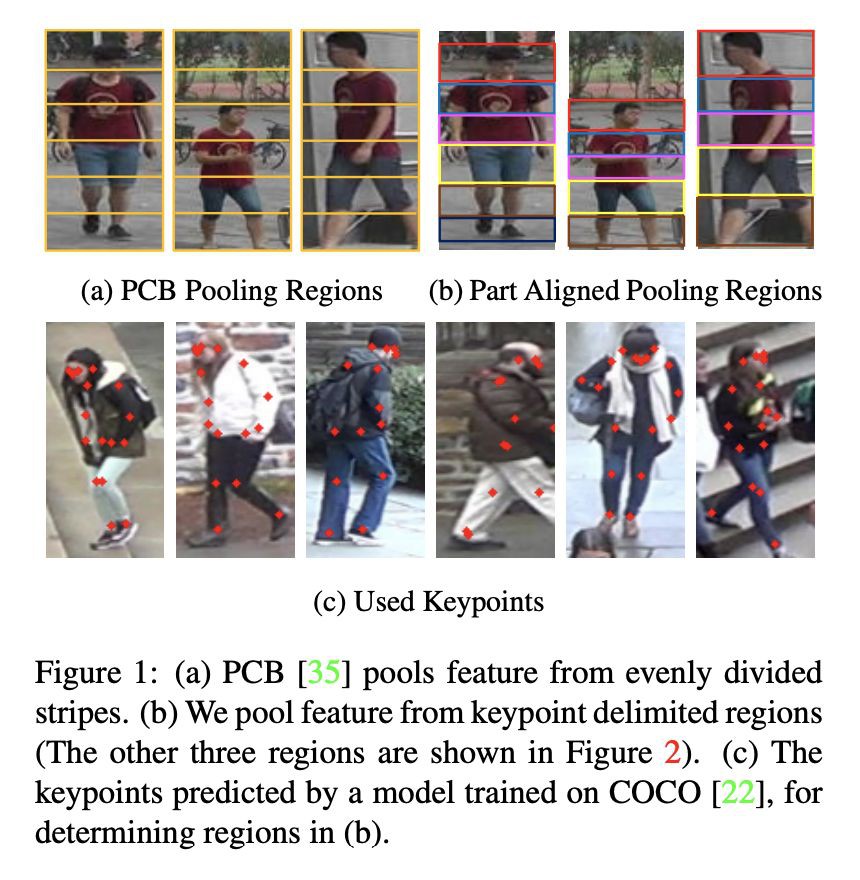

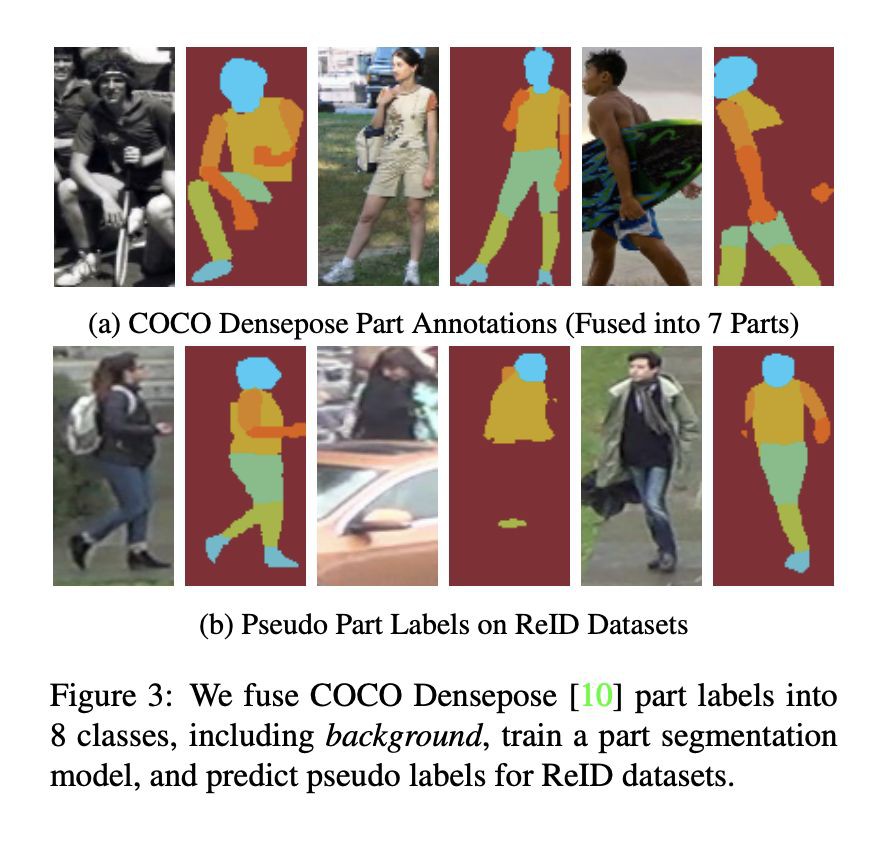

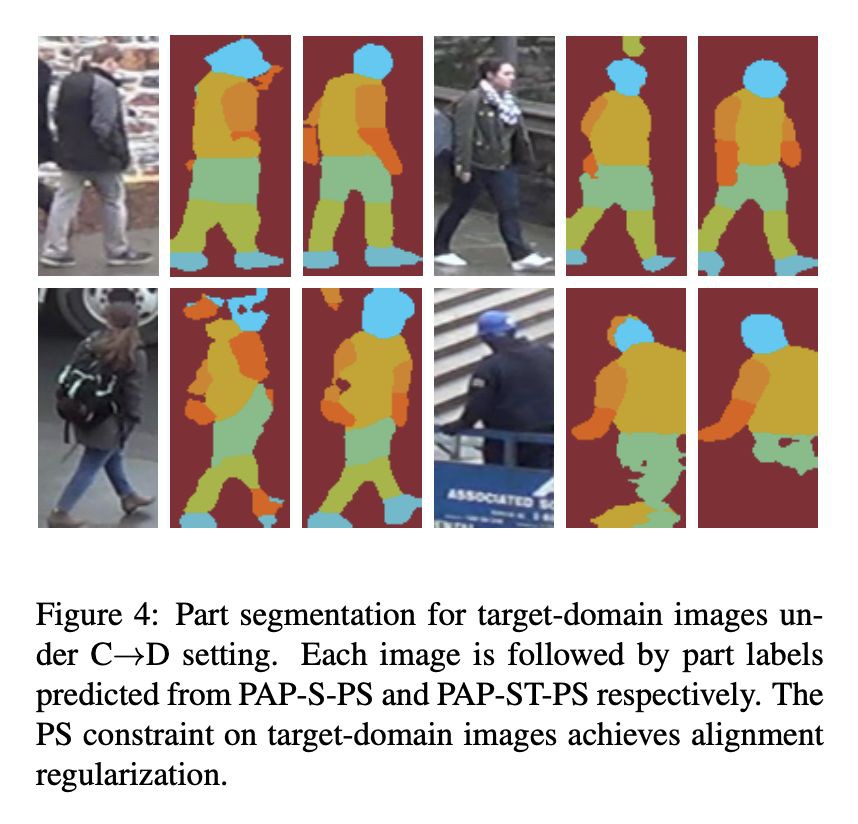

本文來自中科院自動化所和地平線,論文驗證了部件對齊在跨域重識別中起著重要的作用。透過強化模型的對齊,作者透過提高模型的泛化效能來提升模型直接跨庫測試的效能;另一方面,本文提出的部件對齊模型可以很自然地利用標的域無標簽資料實現領域自適應,使得模型可以適配標的域。

作者在 Market1501、CUHK03、DukeMTMC-reID 和 MSMT17 四個目前最大的行人重識別資料庫上證明瞭本文方法的有效性,並且取得了 SOTA 結果。同時,出於完整性,論文還透過實驗證明瞭和現有跨域方法的互補性。

論文連結

https://www.paperweekly.site/papers/2736

原始碼連結

https://github.com/huanghoujing/EANet

@paperweekly 推薦

#Object Detection

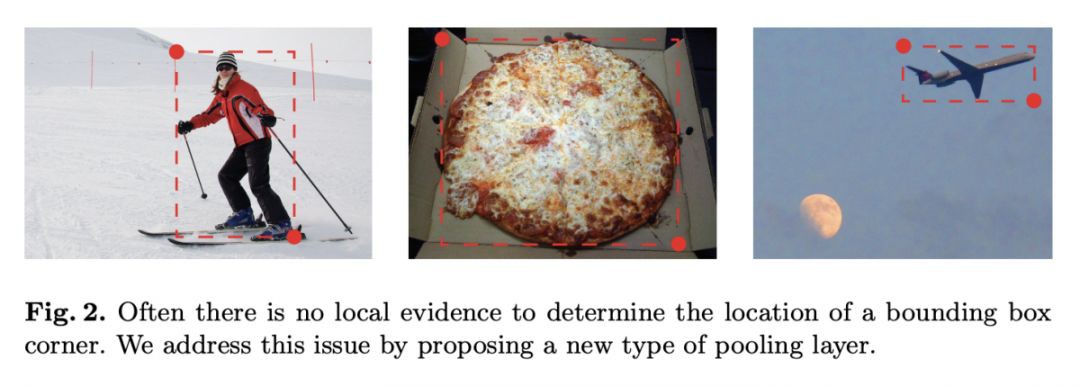

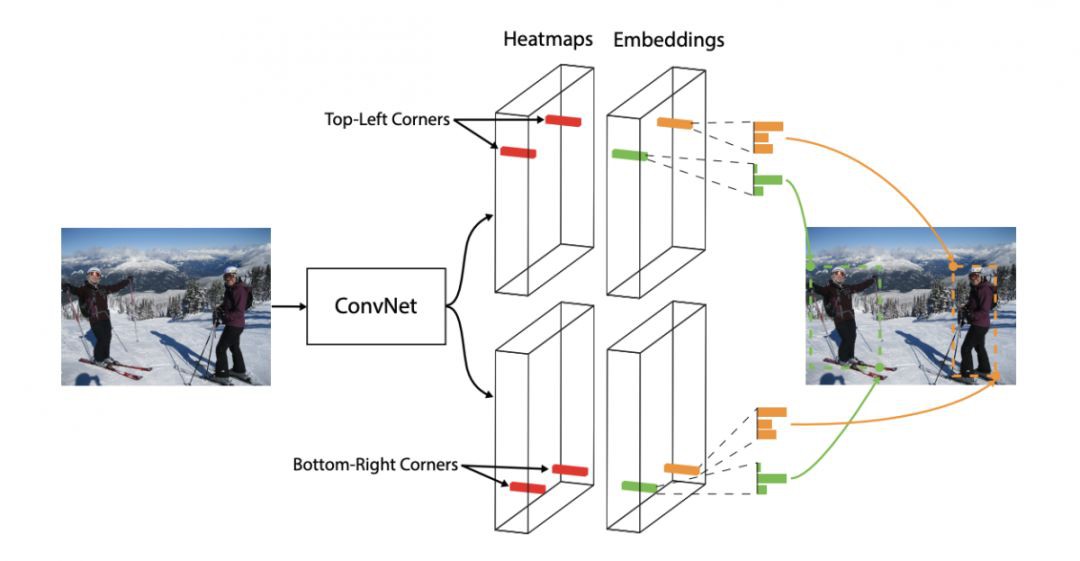

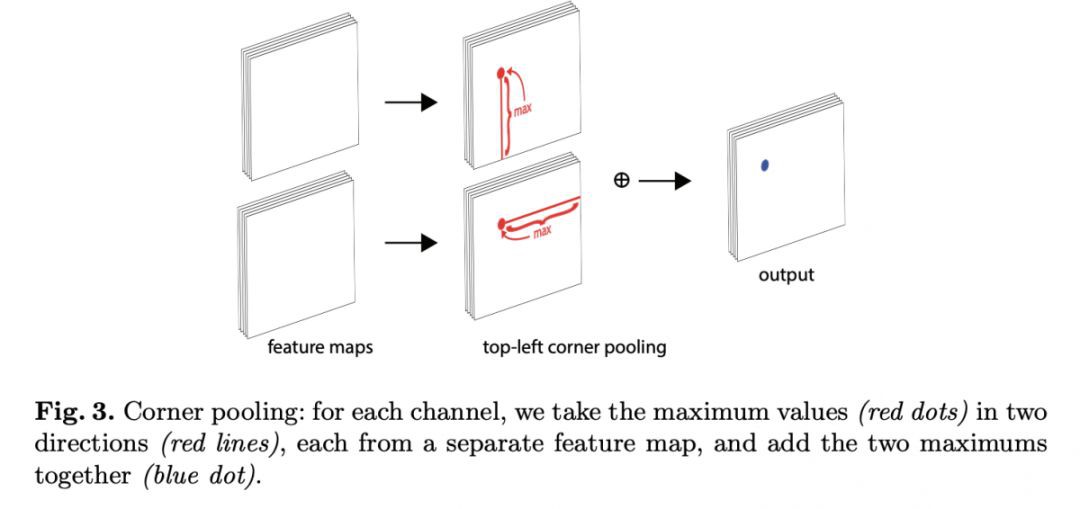

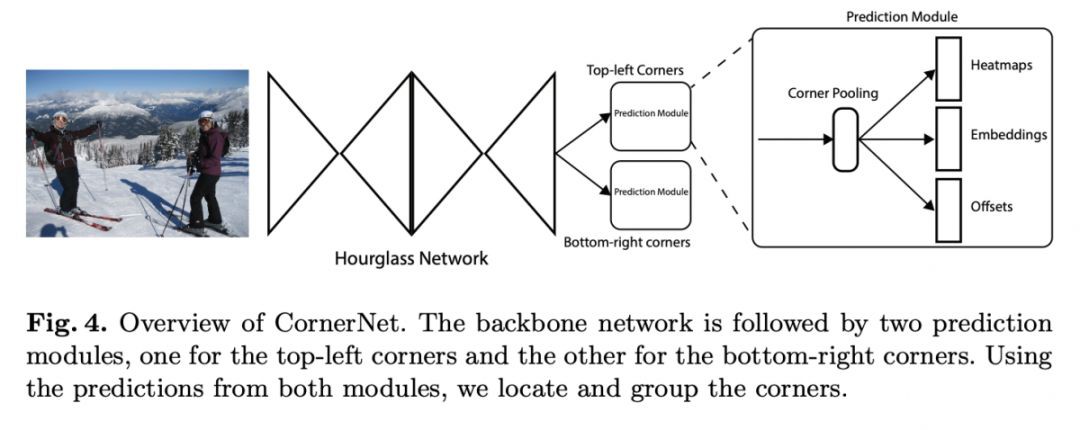

本文是密歇根大學發表於 ECCV 2018 的工作。當前的標的檢測演演算法大多基於 Anchor,引入 Anchor 容易導致正負樣本不均衡和引入更多超引數。本文在不採用 Anchor 的前提下取得了不錯效果,是一篇非常有意思的探索工作。

具體來說,論文借鑒了人體關鍵點檢測的思路來做標的檢測,透過檢測標的框的左上角和右下角兩個關鍵點就能得到預測框。其次,整個檢測網路訓練是從頭開始的,且不基於預訓練的分類模型,這使得使用者能夠自由設計特徵提取網路,不用受預訓練模型的限制。

▲ 論文模型:點選檢視大圖

論文連結

https://www.paperweekly.site/papers/2771

原始碼連結

https://github.com/princeton-vl/CornerNet

@WHUSteven 推薦

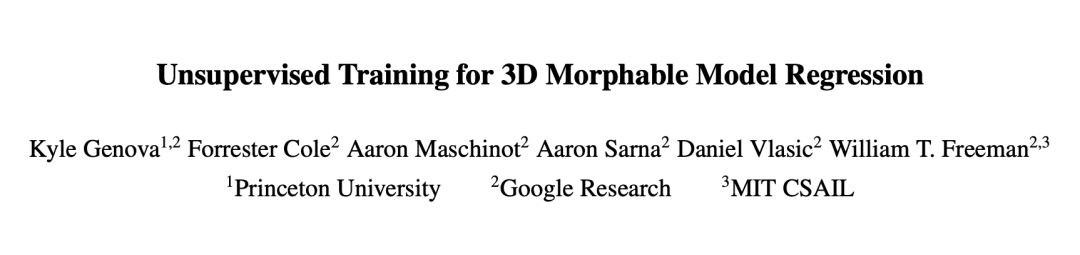

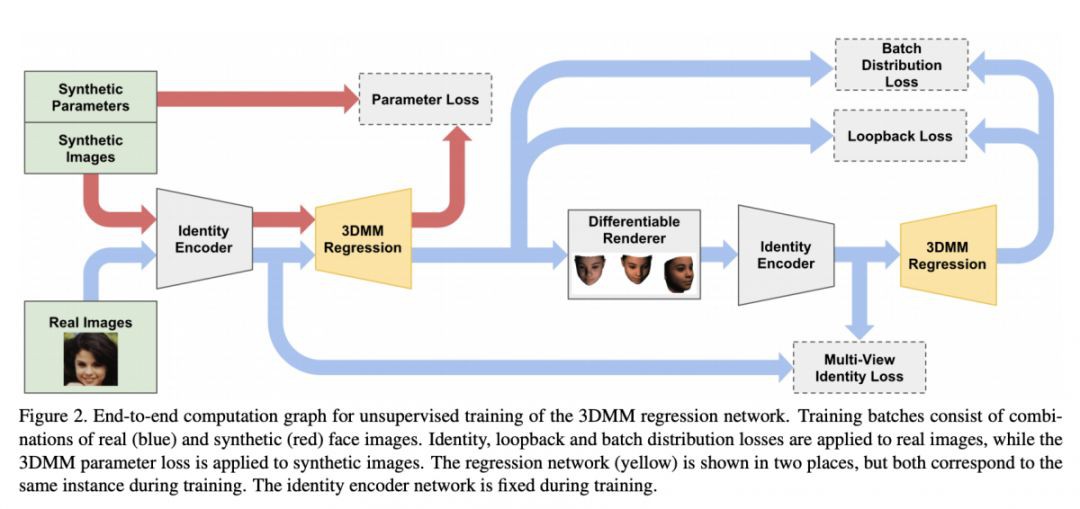

#3D Reconstruction

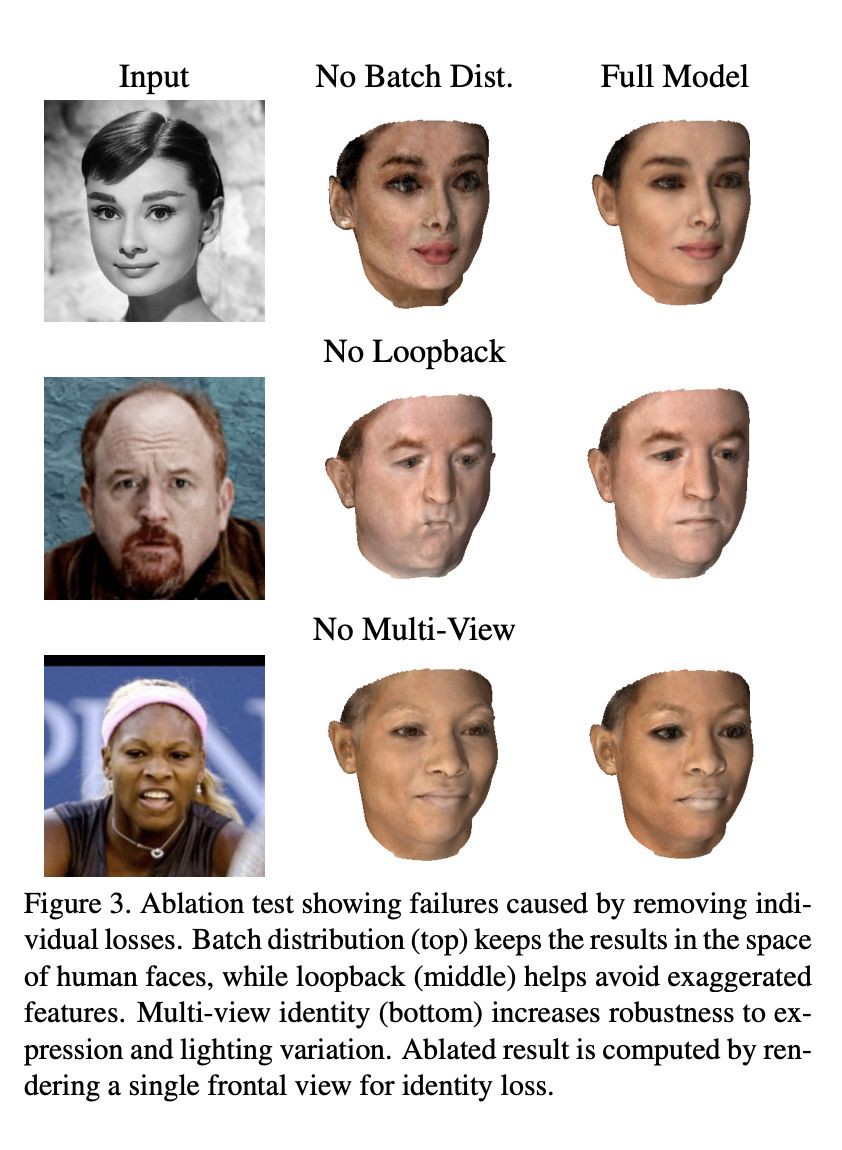

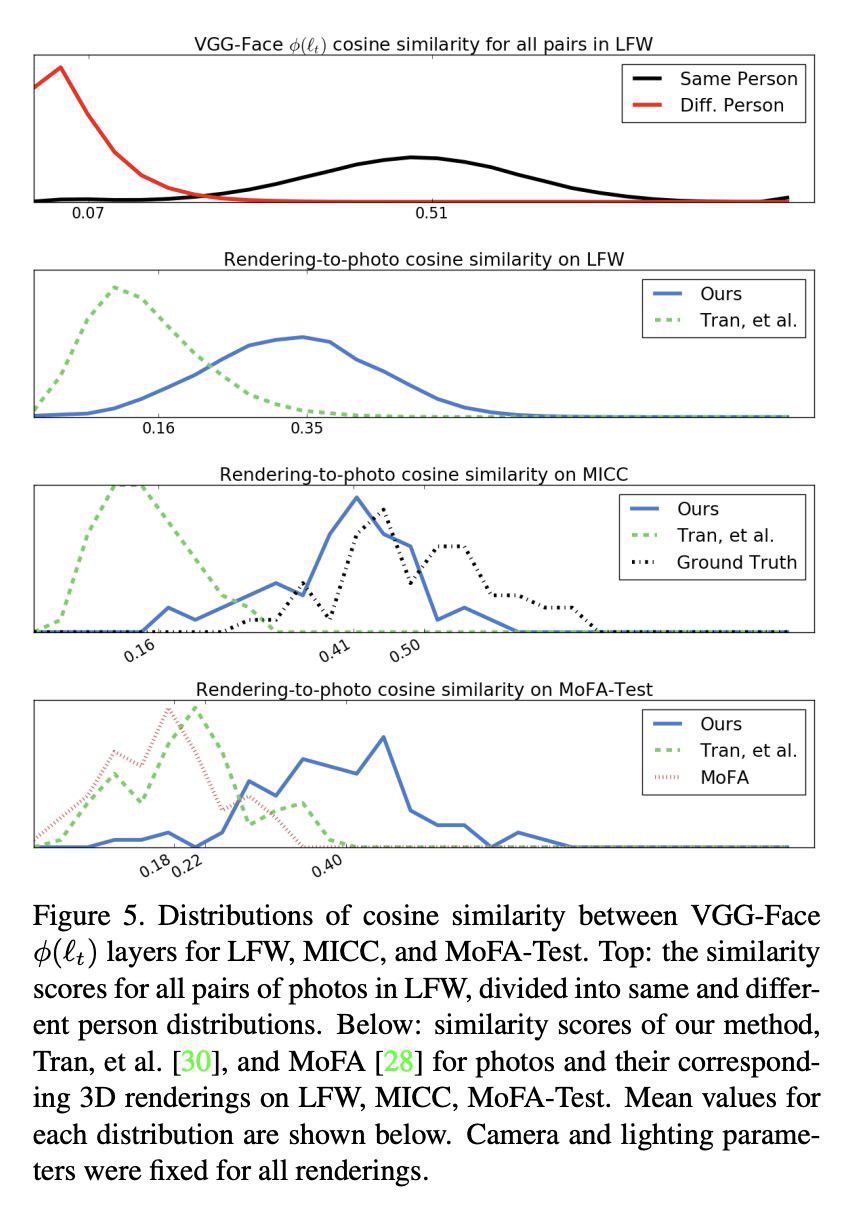

本文是普林斯頓、Google 和 MIT 發表於 CVPR 2018 的工作,論文使用無監督訓練的方法基於 3DMM 進行人臉三維重建。作者主要使用了基於編碼器和解碼器模型,創新性地將人臉識別網路引入訓練的損失函式,使得生成的 3D 人臉能很好地保留了輸入圖片的人臉個體特徵。

該模型旨在擬合形狀和紋理,並沒有學習姿態表情和光照。演演算法的編碼器接受影象作為輸入,輸出用於 3DMM 模型的引數。解碼器接受引數後合成 3D 人臉。

為了使網路不僅能保持個體資訊,還能生成自然真實的人臉,作者提出了 3 個新的損失函式,即批分佈損失(batch distribution loss)、迴環損失(loopback loss)和多視角身份損失(multi-view identity loss)。 批分佈損失可使每個批的統計量與 3DMM 的統計量一致。迴環損失可保證生成的 3D 人臉模型的 2D 成像圖片重新進入編碼器得到的引數和原圖的引數儘量一致。多視角身份損失能使得模型學習到獨立於觀察角度的個體特徵。

實驗結果說明,模型不僅僅可以生成與輸入影象高度相似的 3D 人臉,而且生成的人臉獨立於輸入的表情和姿態,甚至被遮擋的人臉也可以達到不錯的生成效果。

▲ 論文模型:點選檢視大圖

論文連結

https://www.paperweekly.site/papers/2747

原始碼連結

https://github.com/google/tf_mesh_renderer

@whyguu 推薦

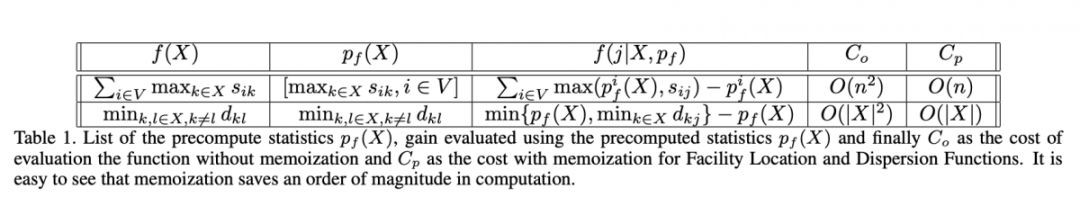

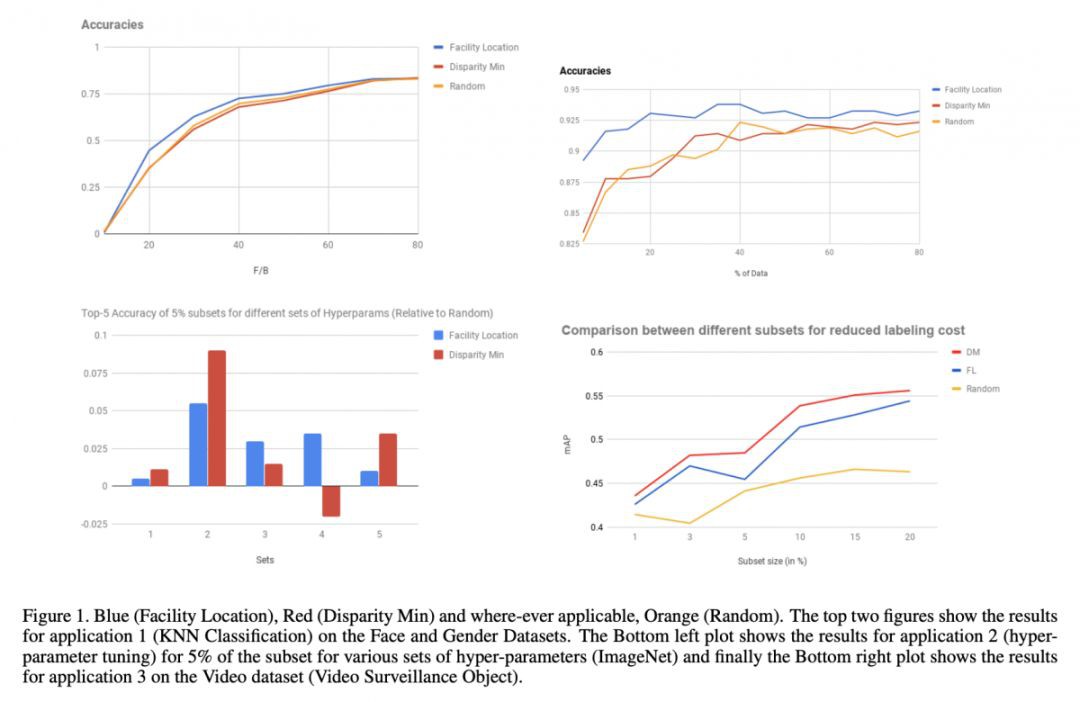

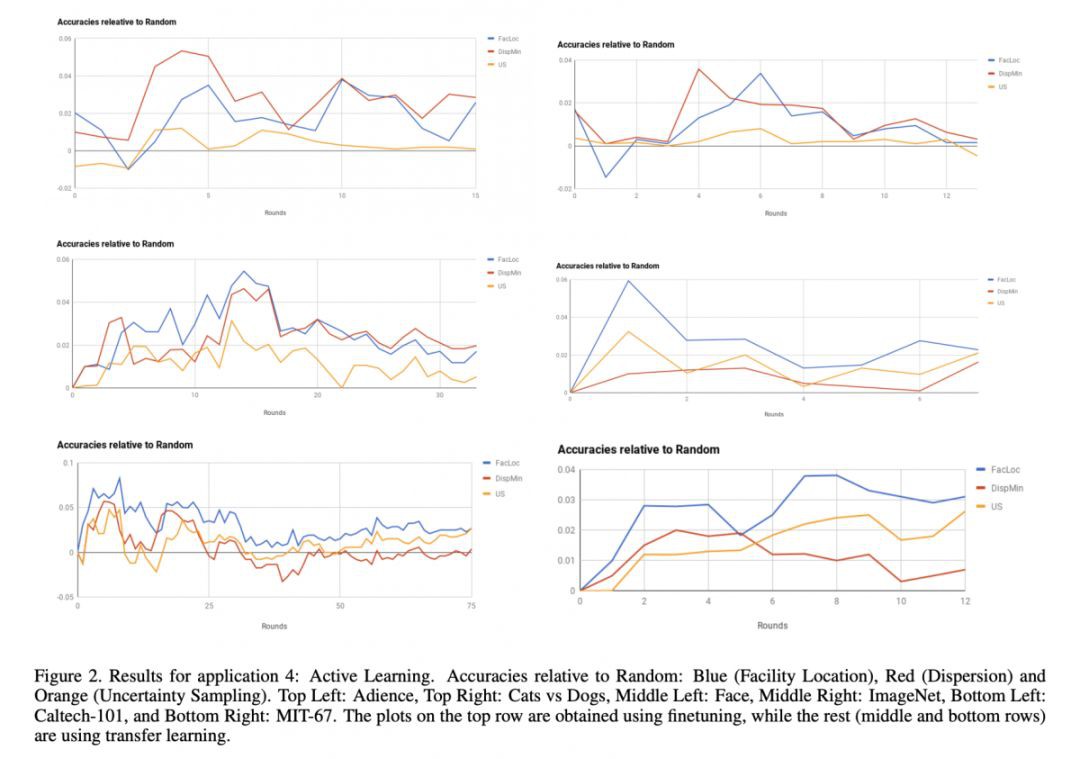

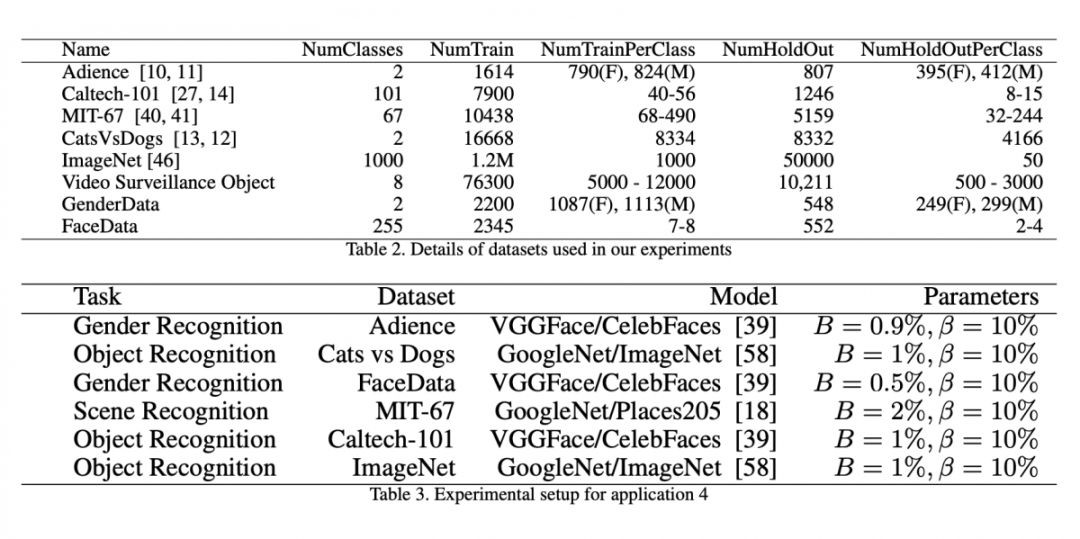

#Active Learning

本文提出了兩種訓練資料集抽取子集的方法 Facility-Location & Disparity-Min。透過抽取的子集來初步表示整個樣本集可以加速網路超引數的最佳化時間。透過從大量無標簽樣本中抽取資料減少標註成本。此外,文章還提供了一種貪婪搜尋演演算法來減少搜尋的時間。做影片或超大樣本學習的同學可以關註一波,看是否有用。

論文連結

https://www.paperweekly.site/papers/2742

@zhangjun 推薦

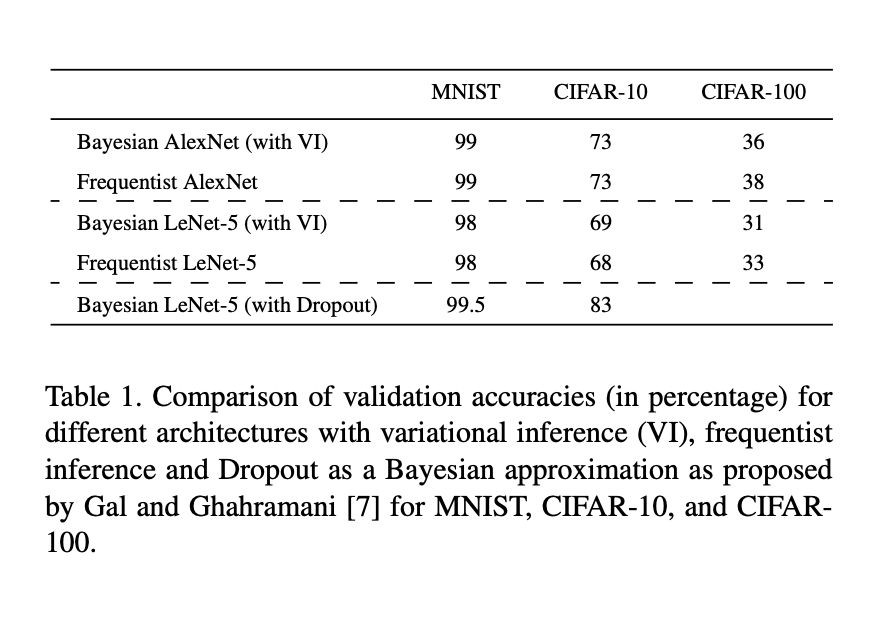

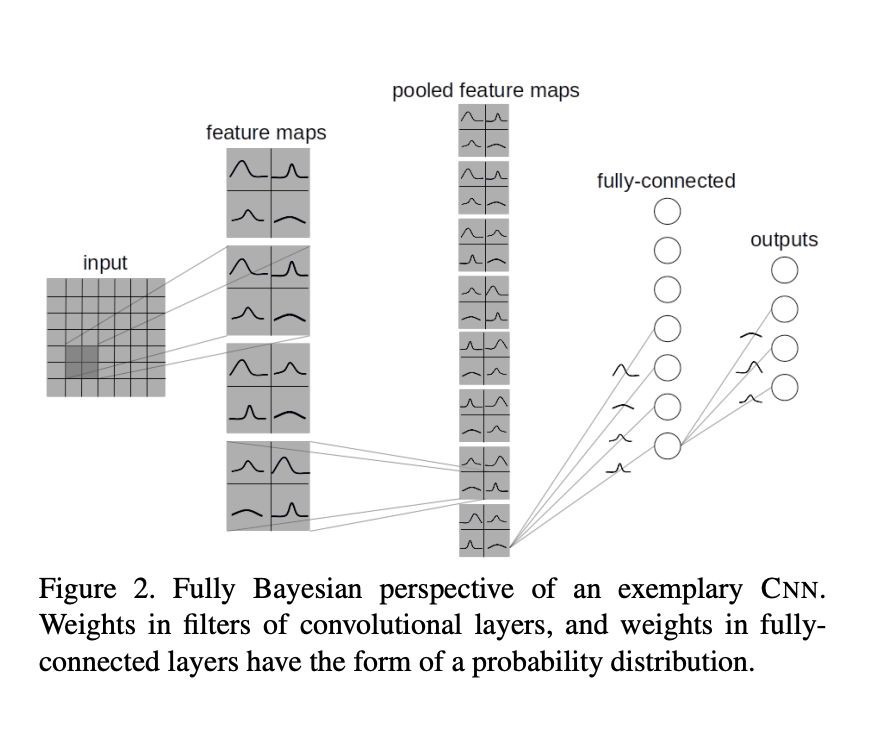

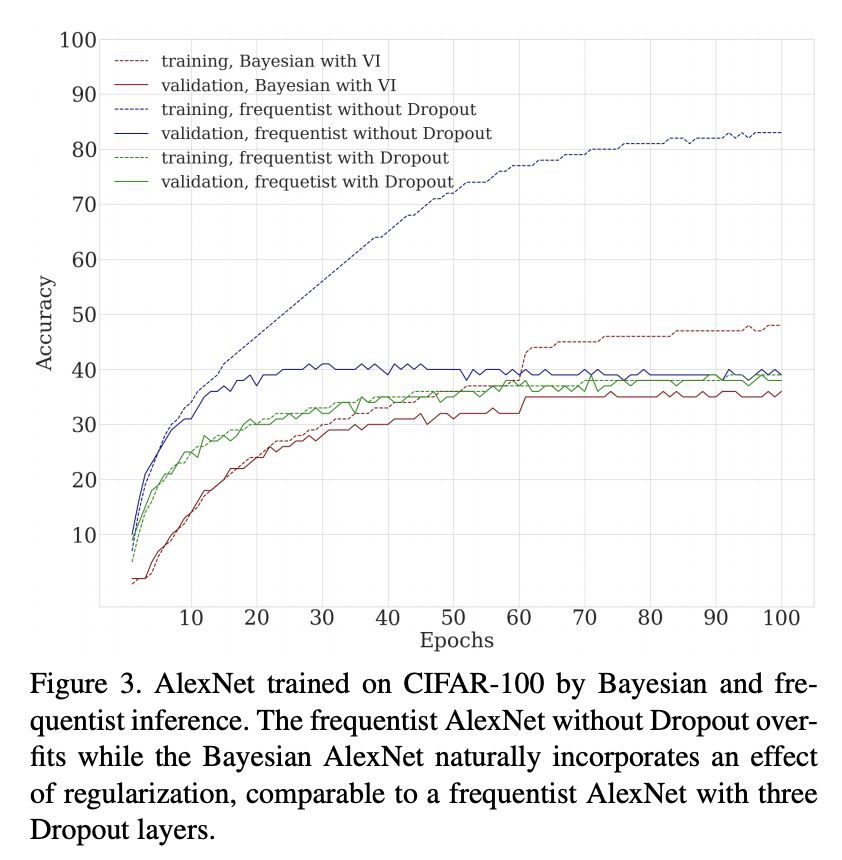

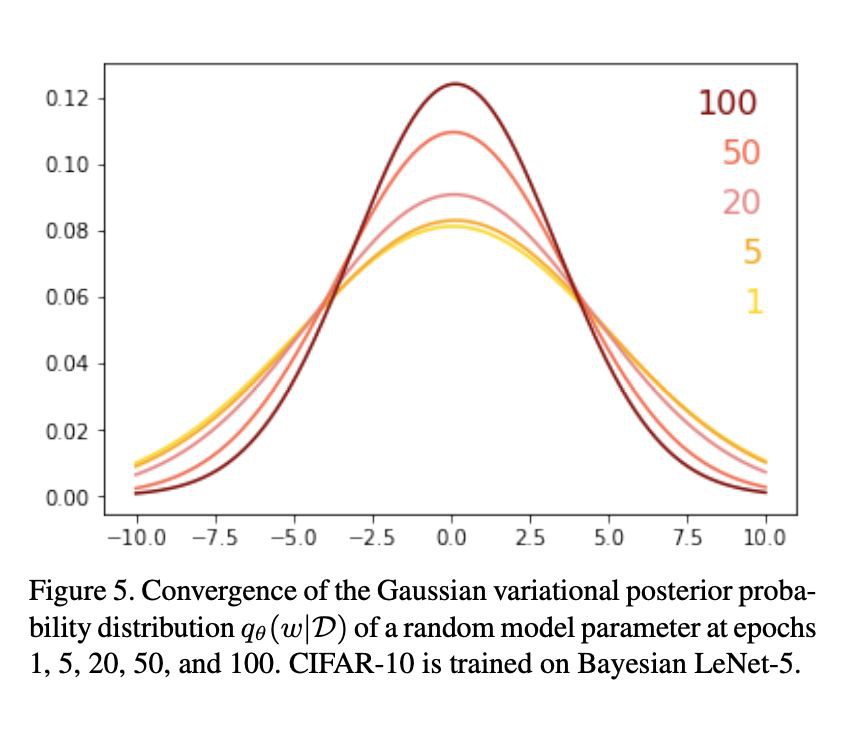

#Bayesian Deep Learning

本文的亮點在於用 Bayes By Backprop 演演算法對 bayesian CNN 的每個引數分佈進行了學習,不同於 Gal 15 年提出的 MC Dropout 的方法,是一種基於貝葉斯後驗推斷的方法。

在此之前,Bayesian MLP 和 RNN 都已有了相應的變分近似求解方法,本文針對 CNN 的摺積層進行了相應的改進,取得了不錯的效果。相比於 Gal 的 MC Dropout 優勢不明顯,而 MC Dropout 的計算效率則快非常多。

論文連結

https://www.paperweekly.site/papers/2731

原始碼連結

https://github.com/felix-laumann/Bayesian_CNN

@QAQ 推薦

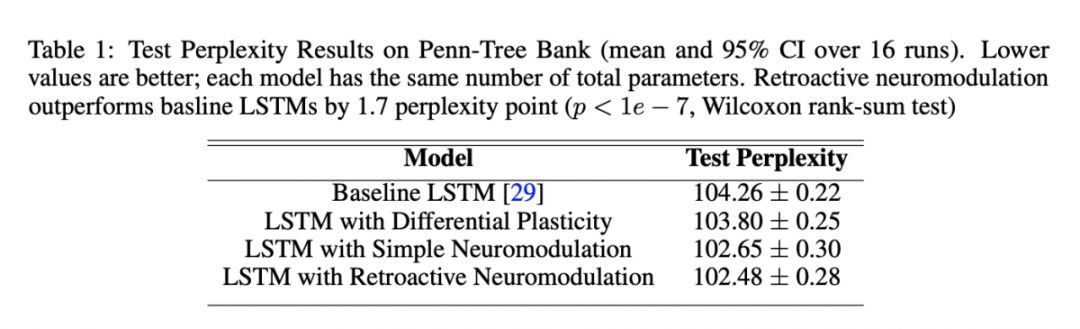

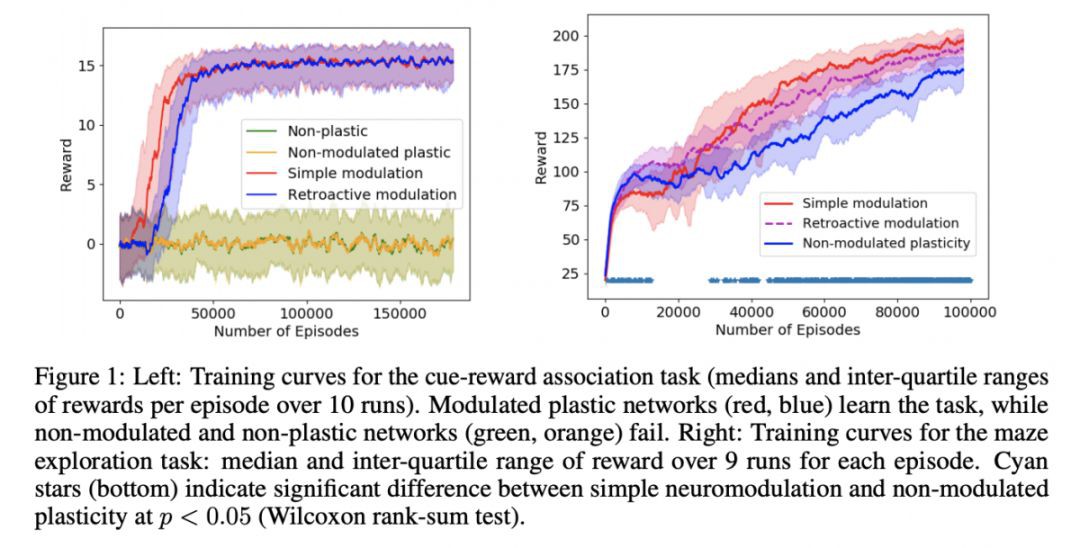

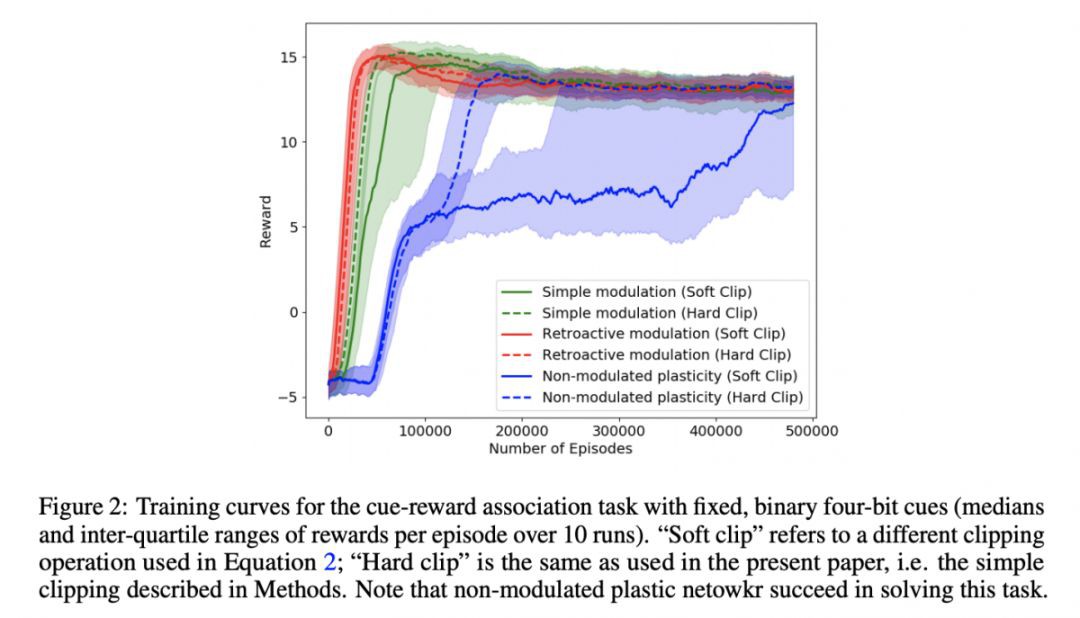

#Neural Networks

本文是 Uber AI Labs 發表於 ICLR 2019 的工作,論文提出了一種受生物學啟發的訓練網路自我修改權重的方法,並且提出了一種可靠的可塑性框架,該框架已經在各種監督學習和強化學習任務上提高了效能,可透過梯度下降進行訓練,為大規模自最佳化神經網路開闢了新的研究方向。實現了學習如何學習(Learning to learn)的網路的基礎。

論文連結

https://www.paperweekly.site/papers/2774

@paperweekly 推薦

#Recommender Systems

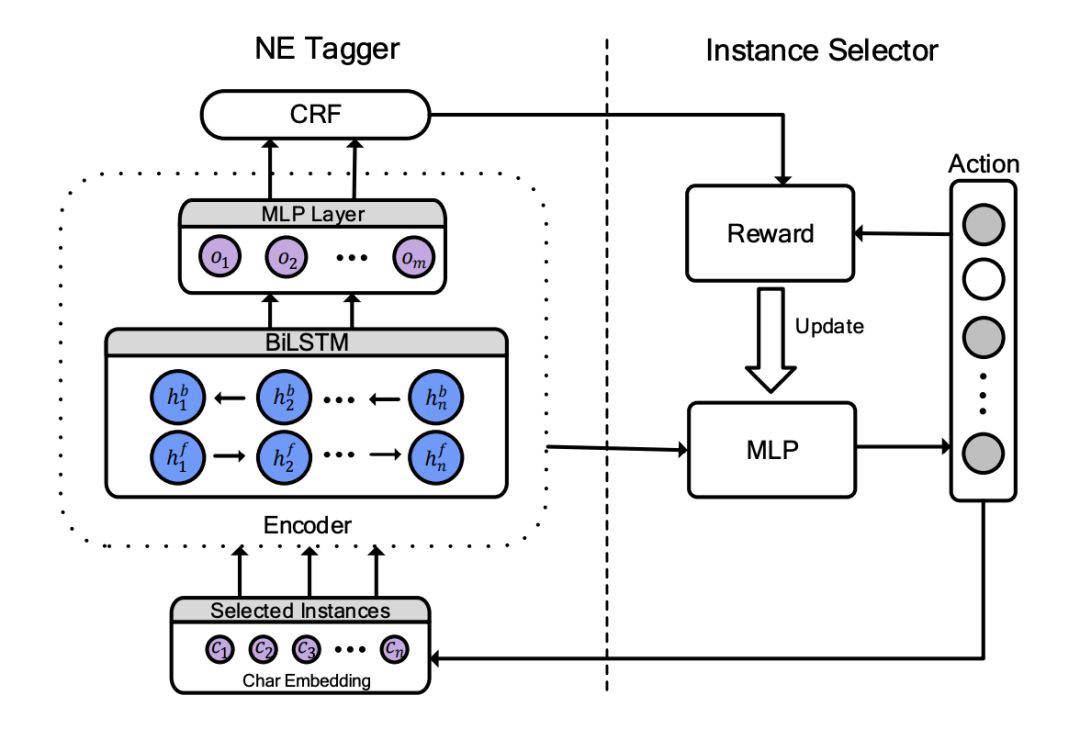

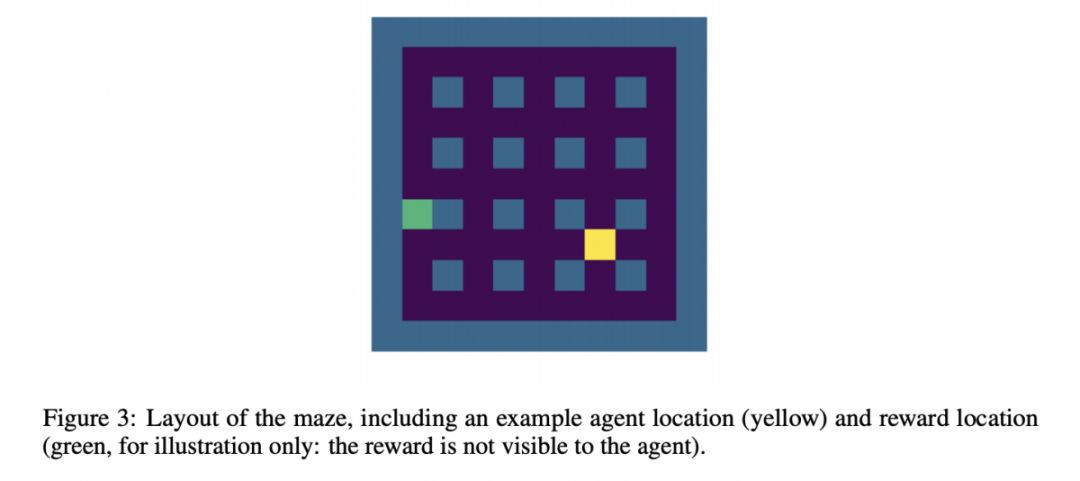

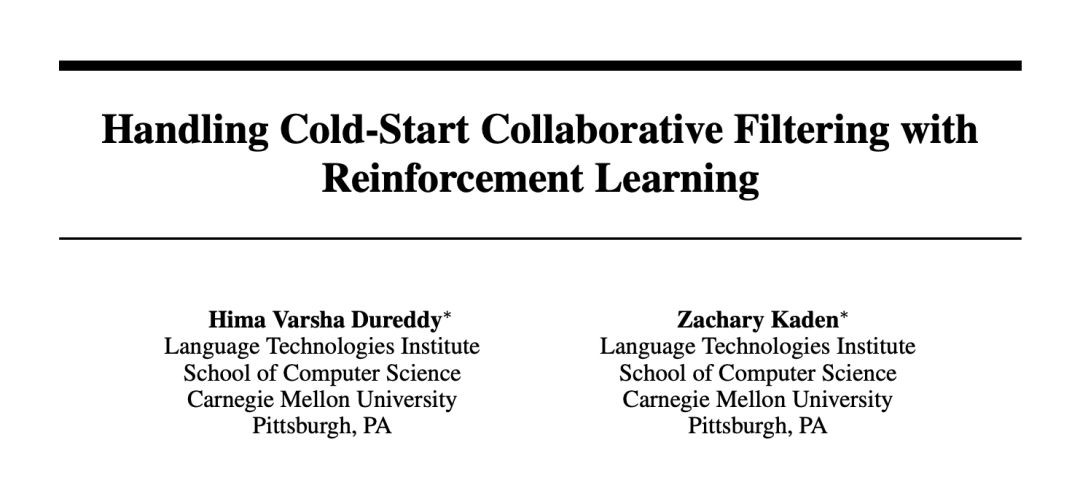

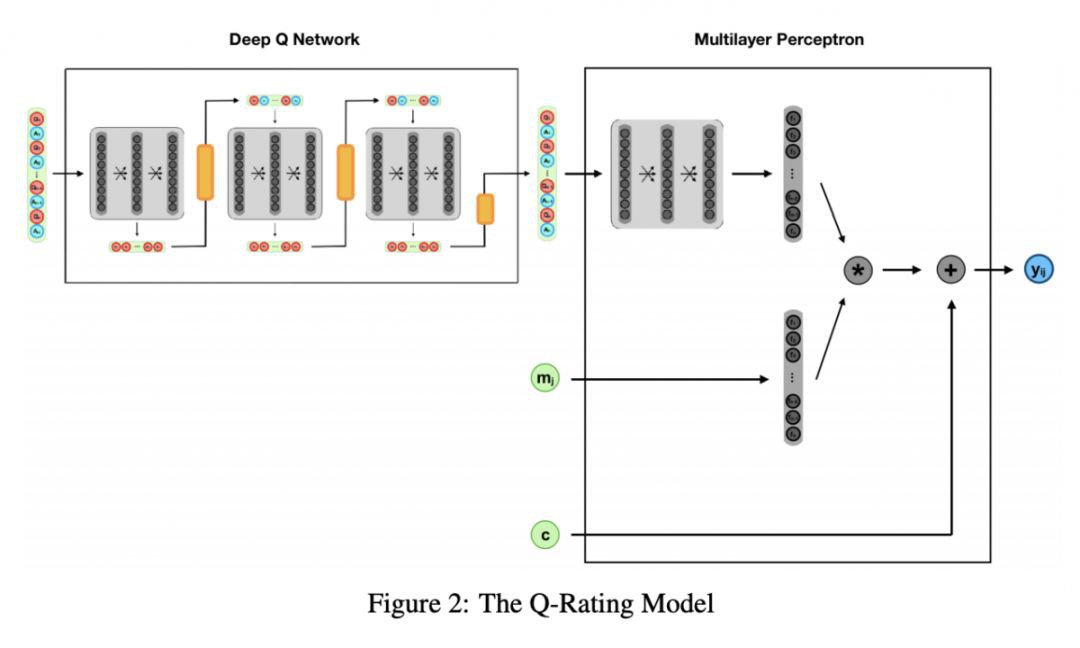

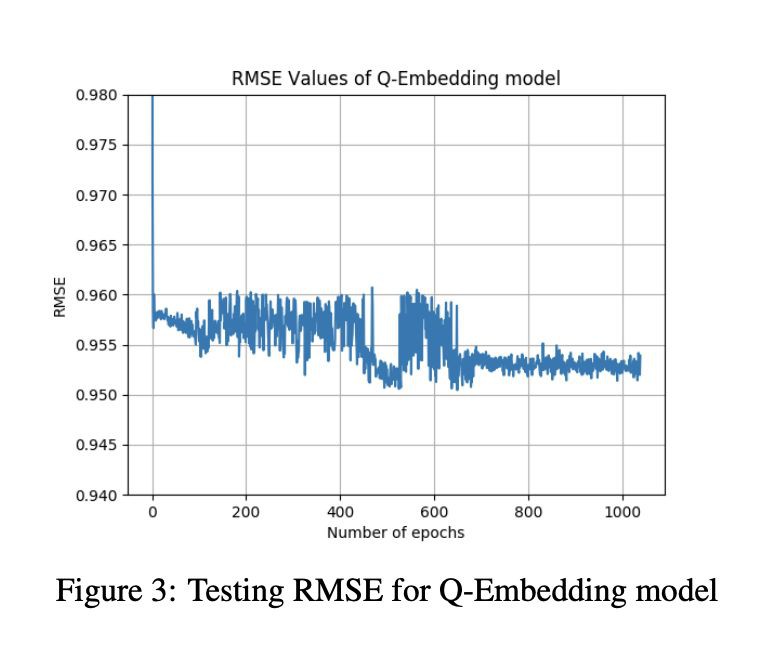

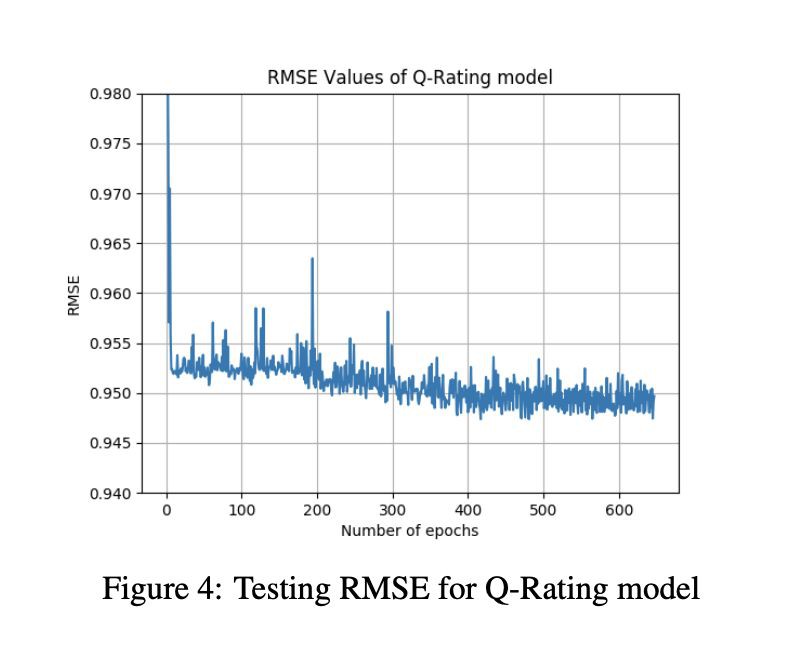

本文來自 CMU。針對協同過濾中的冷啟動問題,作者提出了一種基於 DQN 的問卷調查法來學習如何在電影推薦系統中處理使用者冷啟動。DQN 生成問卷問題,由冷啟動使用者來回答。根據使用者對前一個問題的響應,DQN 將動態生成後續問題。一旦問卷調查完成,問答資訊將被傳遞到多層感知器中(MLP),並生成一個預測的 user embedding。一旦有了 user embedding 和電影 embedding,系統就可以對電影評級進行建模。

論文連結

https://www.paperweekly.site/papers/2691

@wwwangzhch 推薦

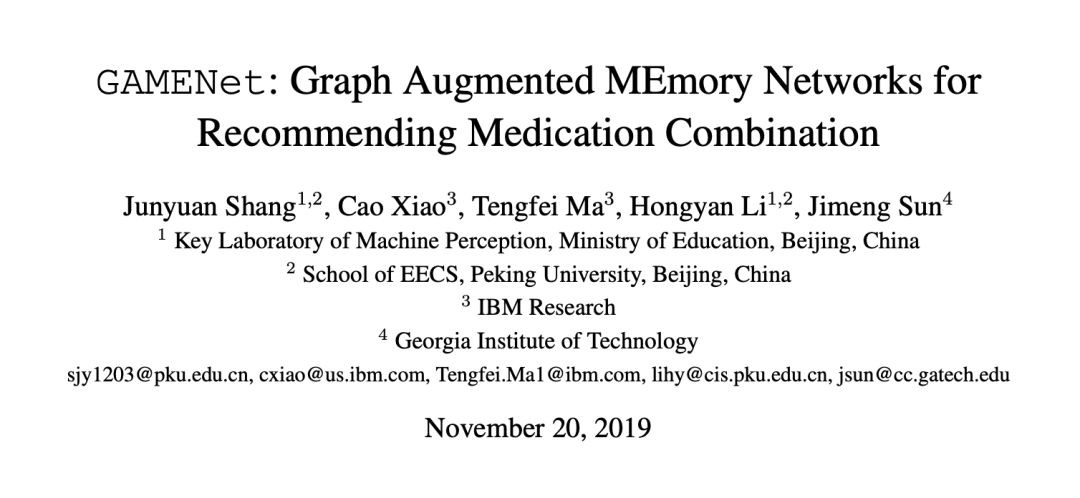

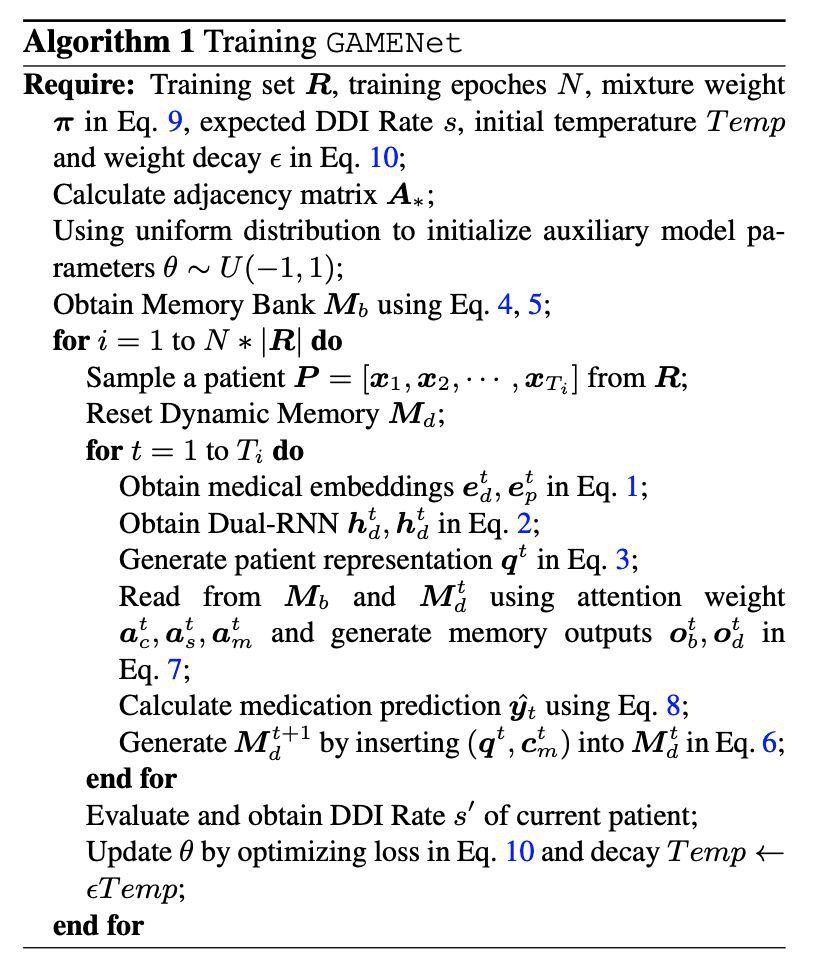

#Memory Networks

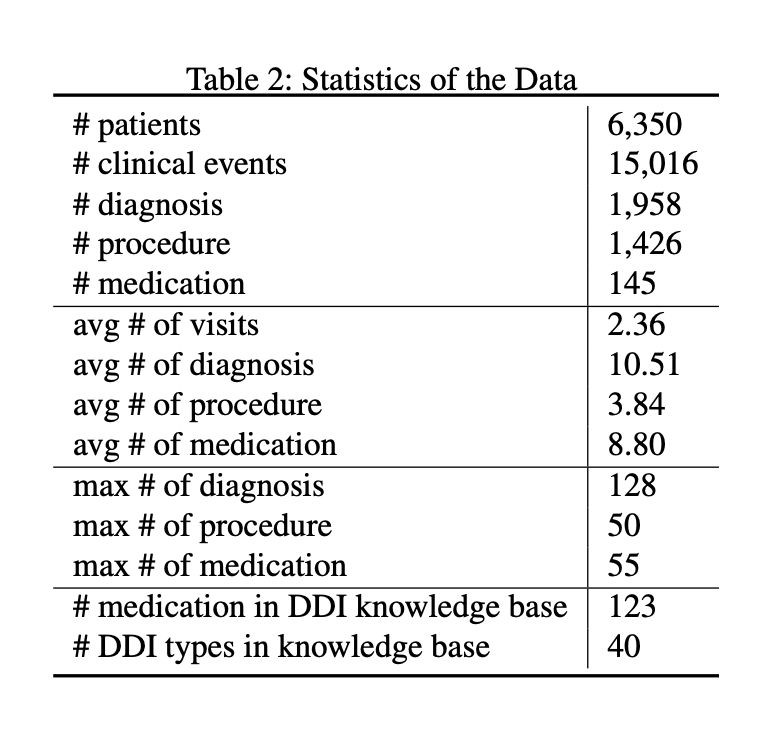

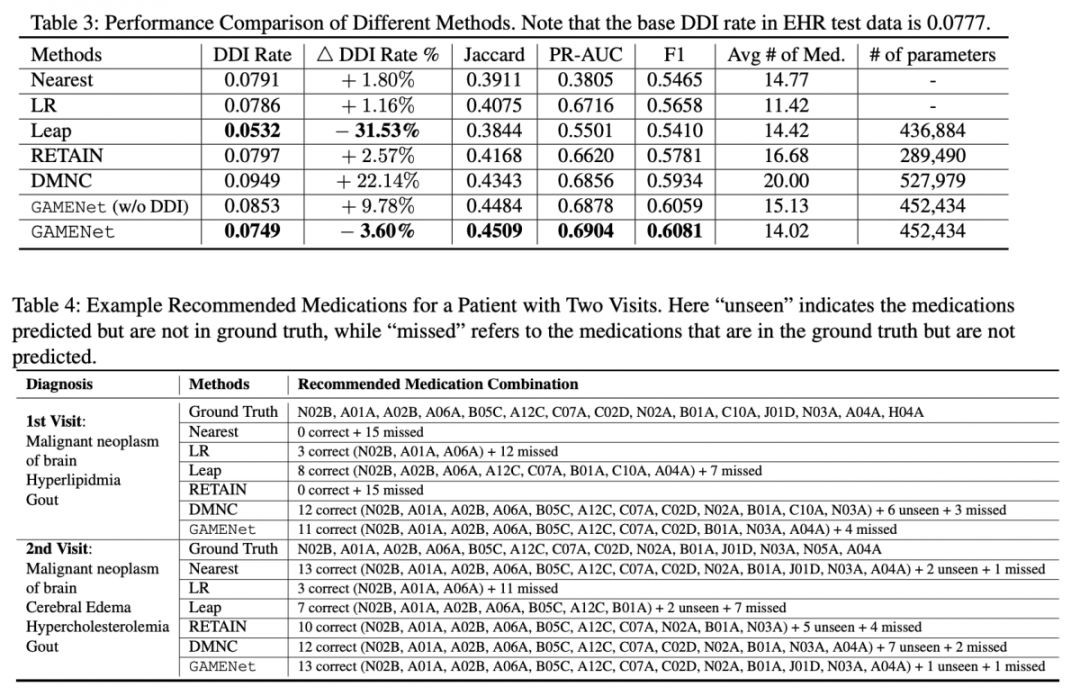

本文是北京大學、IBM 與佐治亞理工發表在 AAAI 2019 上的論文,作者將電子病歷資料(Electronic Health Records, EHR)與藥物相互反應資料(Drug-Drug Interaction, DDI)透過圖摺積網路轉換成 Memory Bank,並結合病人的歷史病歷記錄生成 Dynamic Memory,動態調整損失函式以使得系統在較高精確度與較低 DDI rate 之間權衡,在 MIMIC-III 資料集上使用雅卡爾相似繫數、Average Precision、Average Recall 等多種評價指標均取得了最高的推薦準確率與極低的 DDI rate(僅次於邏輯回歸)。

論文連結

https://www.paperweekly.site/papers/2651

原始碼連結

https://github.com/sjy1203/GAMENet

@zkt18 推薦

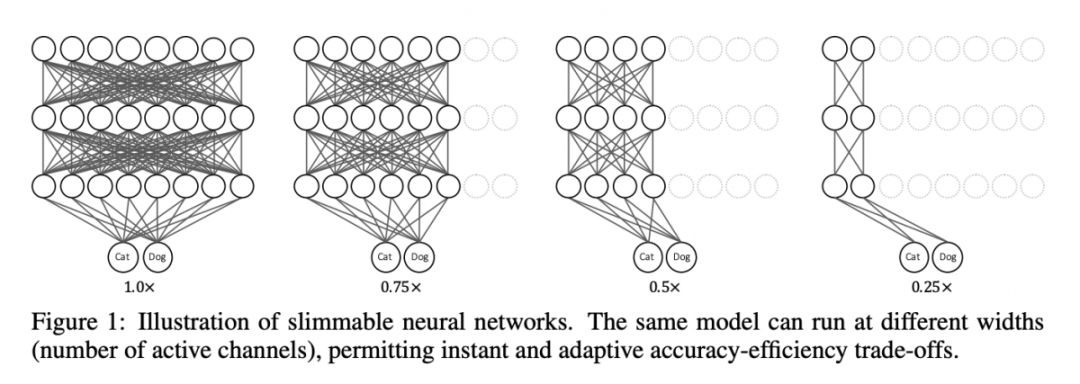

#Neural Networks

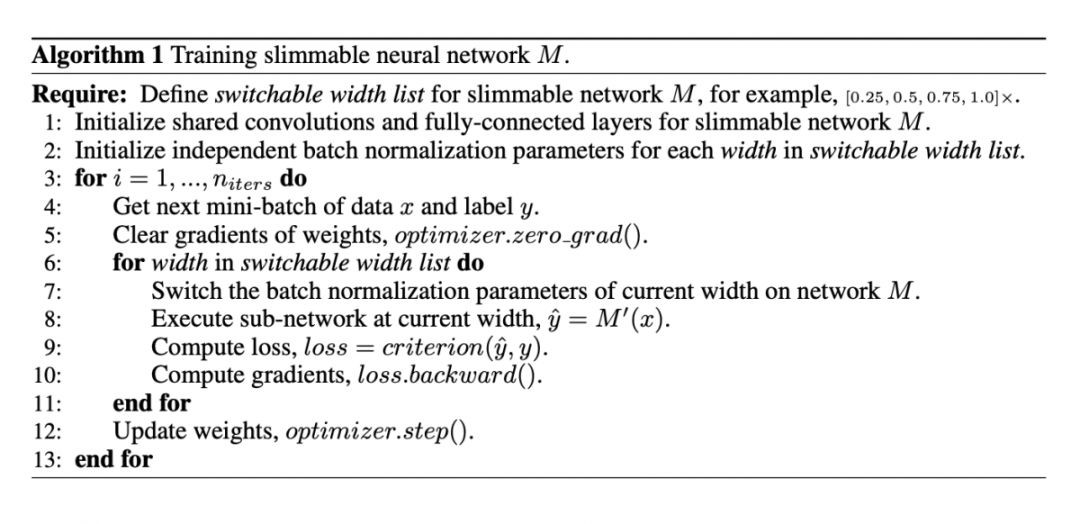

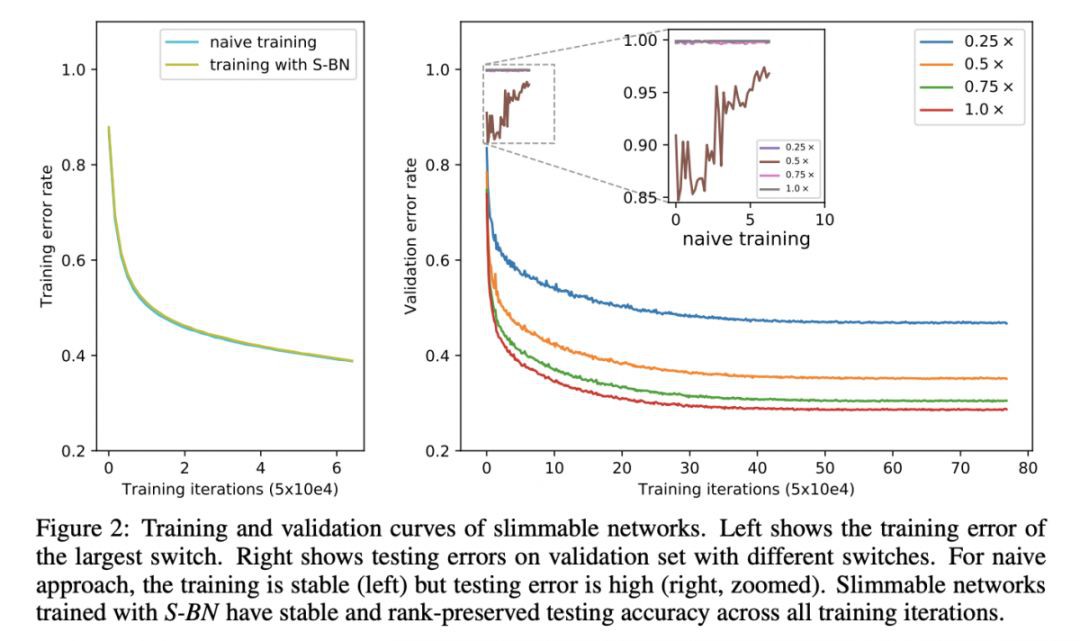

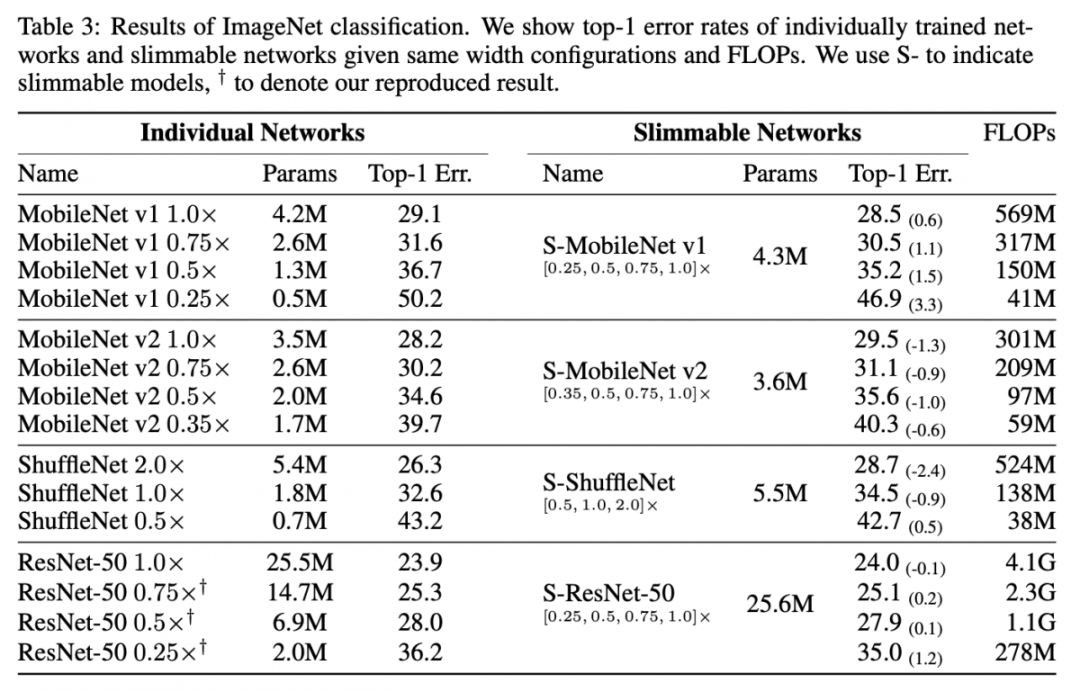

本文是 UIUC、Snap 和位元組跳動發表於 ICLR 2019 的工作,論文提出了一個可瘦身的神經網路,針對不同硬體和執行環境,可以快速提供與之相適應的 CNN 模型來完成任務,支援在移動裝置上進行訓練。

論文連結

https://www.paperweekly.site/papers/2689

原始碼連結

https://github.com/JiahuiYu/slimmable_networks

@ZSCDumin 推薦

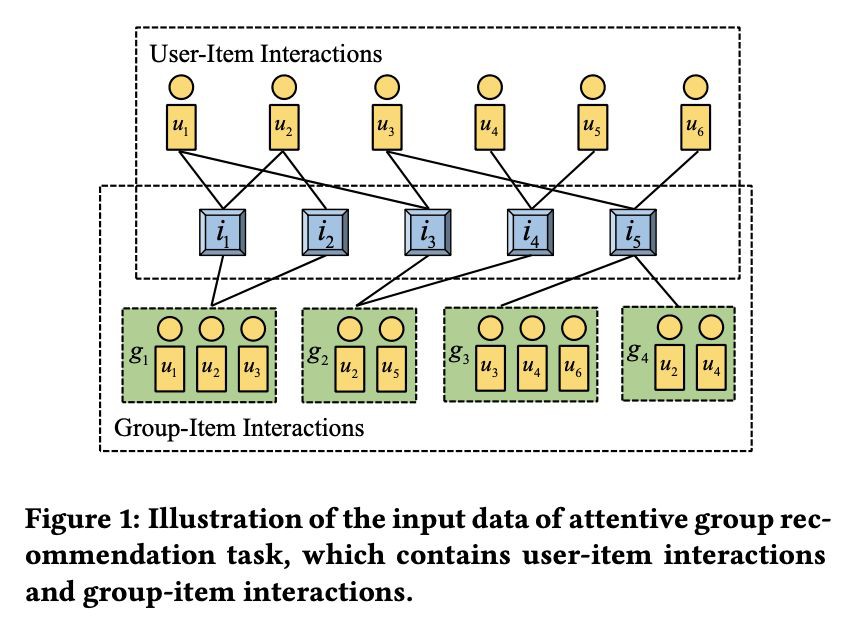

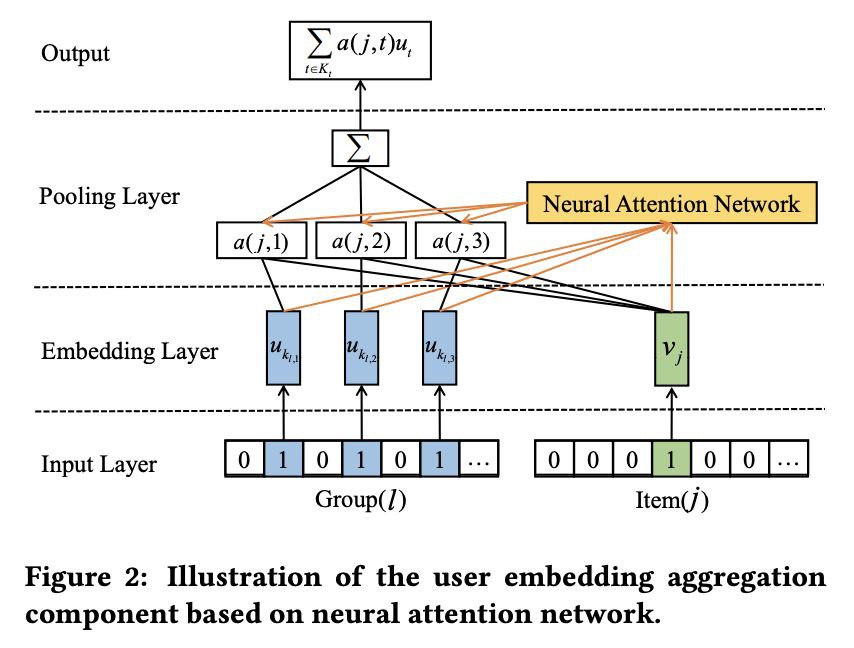

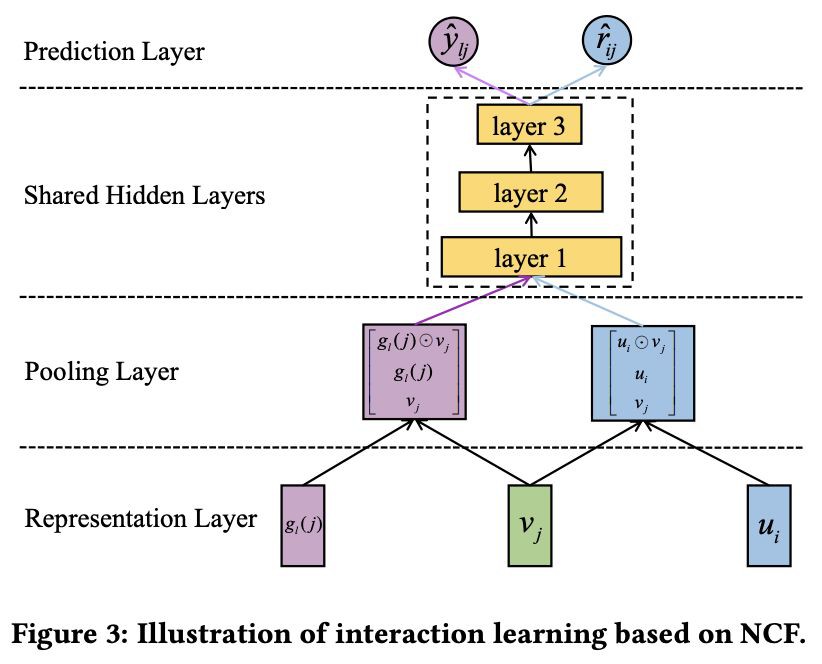

#Group Recommendation

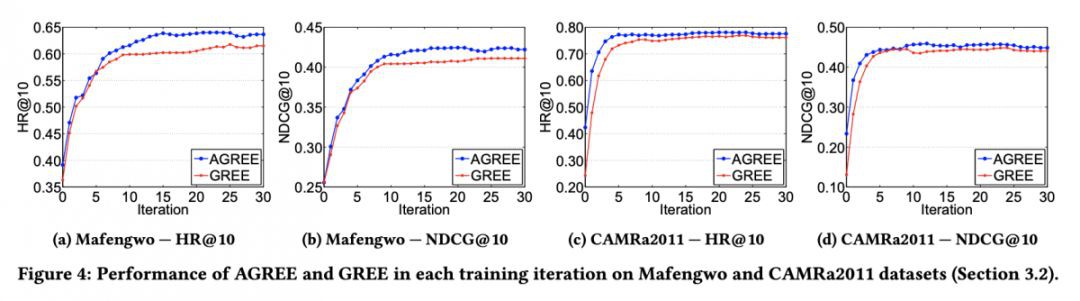

本文是湖南大學和新加坡國立大學發表於 SIGIR 2018 的工作,論文應用神經協同網路和註意力機製為群組使用者進行 Top-N 商品推薦,主要解決了群組使用者興趣的動態組合、群組與個人使用者的協同商品推薦,以及新使用者的冷啟動問題。

論文連結

https://www.paperweekly.site/papers/2732

原始碼連結

https://github.com/LianHaiMiao/Attentive-Group-Recommendation

#推 薦 有 禮#

#推 薦 有 禮#

本期所有入選論文的推薦人

均將獲得PaperWeekly紀念周邊一份

▲ 深度學習主題行李牌/卡套 + 防水貼紙

禮物領取方式

推薦人請根據論文詳情頁底部留言

新增小助手領取禮物

*每位使用者僅限領取一次

想要贏取以上週邊好禮?

點選閱讀原文即刻推薦論文吧!

點選以下標題檢視往期推薦:

#投 稿 通 道#

#投 稿 通 道#

讓你的論文被更多人看到

如何才能讓更多的優質內容以更短路徑到達讀者群體,縮短讀者尋找優質內容的成本呢? 答案就是:你不認識的人。

總有一些你不認識的人,知道你想知道的東西。PaperWeekly 或許可以成為一座橋梁,促使不同背景、不同方向的學者和學術靈感相互碰撞,迸發出更多的可能性。

PaperWeekly 鼓勵高校實驗室或個人,在我們的平臺上分享各類優質內容,可以是最新論文解讀,也可以是學習心得或技術乾貨。我們的目的只有一個,讓知識真正流動起來。

知識星球

知識星球