筆者邀請您,先思考:

1 您在面試資料的工作,遇到什麼資料科學面試題?

資料科學也被稱為資料驅動型決策,是一個跨學科領域,涉及以各種形式從資料中提取知識的科學方法,過程和系統,並基於這些知識進行決策。 資料科學家不應僅僅根據他/她對機器學習的知識進行評估,而且他/她也應該具有良好的統計專業知識。 我將嘗試從非常基礎的資料科學入手,然後慢慢轉向專家級。 所以讓我們開始吧。

1.有監督和無監督機器學習有什麼區別?

監督機器學習:

監督機器學習需要訓練標記資料。

無監督機器學習:

無監督機器學習不需要標記資料。

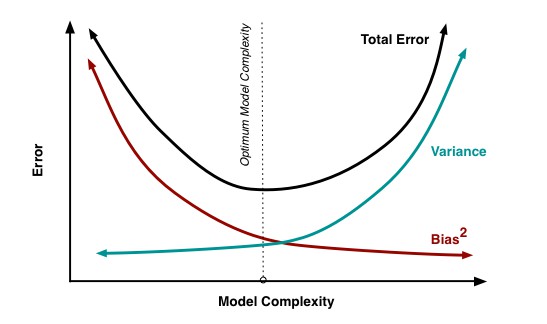

2.什麼是偏差,方差,如何平衡?

偏差:

“由於過度簡化了機器學習演演算法,偏差是在您的模型中引入的錯誤。”它可能導致欠擬合。當你訓練你的模型時,模型會做出簡化的假設,使標的函式更易於理解。

低偏差機器學習演演算法 – 決策樹,k-NN和SVM

高偏差機器學習演演算法 – 線性回歸,Logistic回歸

方差:

“由於複雜的機器學習演演算法導致模型中引入了誤差,您的模型也會從訓練資料集中學習噪聲,併在測試資料集上執行錯誤。”它會導致高靈敏度和過度擬合。

通常,當你增加模型的複雜性時,由於模型中偏差較小,你會看到誤差減少。但是,這隻發生在特定的點。隨著你繼續讓你的模型變得更加複雜,你最終會過度擬合你的模型,因此你的模型將開始承受高方差。

偏差與方差平衡

任何有監督的機器學習演演算法的標的是具有低偏差和低方差以實現良好的預測效能。

k最近鄰演演算法具有低偏差和高方差,但是可以透過增加k的值來改變權衡,這增加了對預測有貢獻的鄰居數量,並且反過來增加了模型的偏差。

支援向量機演演算法具有低偏差和高方差,但是可以透過增加影響訓練資料中允許的邊緣違規次數的C引數來改變權衡,這增加了偏差但減小了方差。

無法避免機器學習中偏差和方差之間的關係。

增加偏差會降低方差。 增加方差會減少偏差。

3.什麼是梯度爆炸?

“梯度爆炸是一個問題,在訓練過程中,大量梯度誤差累積以導致神經網路模型權重的非常大的更新。”極端情況下,權重的值可能變得很大以致上限溢位並導致NaN值。

這會導致您的模型不穩定,無法從您的訓練資料中學習。 現在我們來瞭解什麼是梯度。

梯度:

梯度是在訓練神經網路時計算的方向和大小,用於以正確的方向和正確的數量更新網路權重。

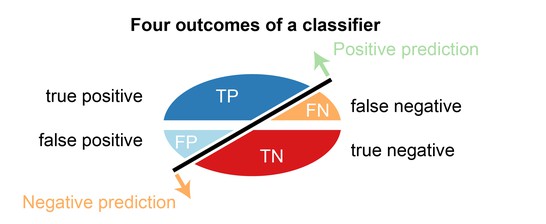

4.什麼是混淆矩陣?

混淆矩陣是一個2X2表,其中包含由二進位制分類器提供的4個輸出。 諸如誤差率,準確性,特異性,靈敏度,精密度和召回率等各種測量方法都是從中推匯出來的。 混淆矩陣

用於效能評估的資料集稱為測試資料集。 它應該包含正確的標簽和預測標簽。

如果二元分類器的效能是完美的,預測標簽將完全相同。

預測標簽通常與真實世界場景中觀察到的部分標簽相匹配。

二元分類器可以將測試資料集的所有資料實體預測為陽性或陰性。 這產生了四個結果 –

真陽性(TP) – 正確的陽性預測

假陽性(FP) – 錯誤的陽性預測

真陰性(TN) – 正確的陰性預測

假陰性(FN) – 錯誤的陰性預測

從混淆矩陣匯出的基本度量

錯誤率=(FP + FN)/(P + N)

準確度=(TP + TN)/(P + N)

靈敏度(召回率或真陽性率)= TP / P

特異性(真陰性率)= TN / N

精度(正向預測值)= TP /(TP + FP)

F分數(精度和召回率的諧波平均值)=(1 + b)(PREC.REC)/(b ^ 2PREC + REC)其中b通常是0.5,1,2。

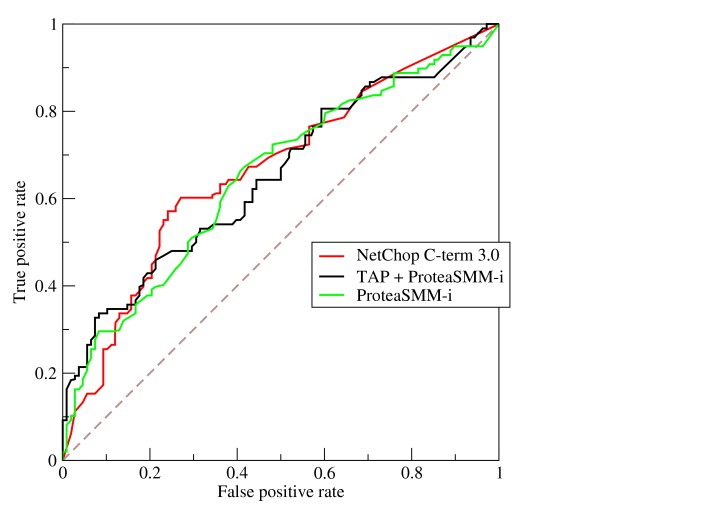

5.解釋ROC曲線是如何工作的?

ROC曲線是各種閾值下真陽性率和假陽性率之間對比的圖形表示。 它通常被用作敏感度(真正的陽性率)和假陽性率之間折衷的代理。

6.什麼是選擇偏差?

當抽取的樣本不能代表所分析的總體時,就會發生選擇新偏差。

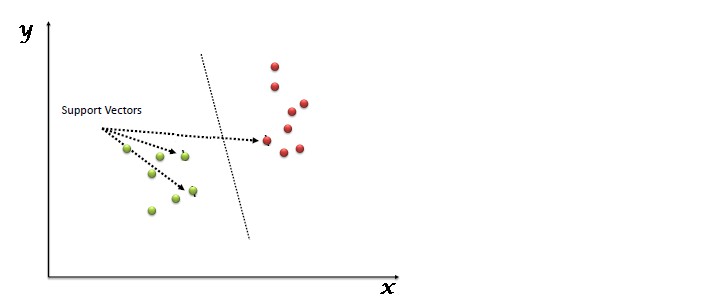

7.詳細解釋SVM機器學習演演算法。

SVM代表支援向量機,它是一種可用於回歸和分類的監督機器學習演演算法。 如果訓練資料集中有n個特徵,則SVM會嘗試將其繪製在n維空間中,每個特徵的值都是特定坐標的值。

SVM使用超平面根據提供的核心函式分離出不同的類。

8. SVM中的支援向量是什麼

在上圖中,我們看到,較細的線標記從分類器到稱為支援向量(變暗的資料點)的最近資料點的距離。 兩條細線之間的距離稱為邊距。

9. SVM中的不同核心函式有哪些?

SVM中有四種型別的核心。

-

線性核心

-

多項式核心

-

徑向基核

-

Sigmoid核心

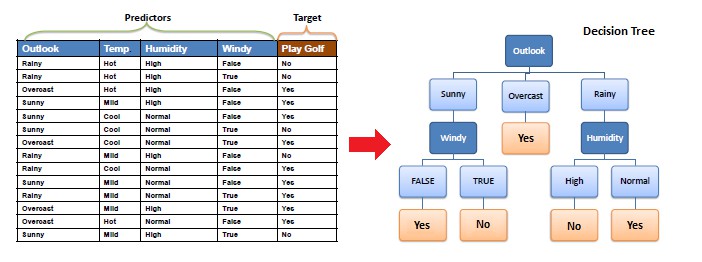

10.詳細解釋決策樹演演算法。

決策樹是一種主要用於回歸和分類的監督機器學習演演算法。它將資料集分解成越來越小的子集,同時逐步開發相關的決策樹。 最終的結果是一個帶有決策節點和葉節點的樹。 決策樹可以處理類別和數值資料。

11.什麼是決策樹演演算法中的熵和資訊增益?

構建決策樹的核心演演算法叫做ID3。 ID3使用Enteropy和Information Gain來構建決策樹。

熵

決策樹是從根節點自上而下構建的,涉及將資料劃分為同質子集。 ID3使用enteropy來檢查樣本的同質性。 如果樣本是完全同質的,那麼熵是零,如果樣本是等分的,則它的熵是1。

資訊收益

資訊增益基於資料集在屬性上分割後熵的減少。 構建決策樹都是為了找到傳回最高資訊增益的屬性。

12.什麼是決策樹中的修剪?

當我們刪除決策節點的子節點時,這個過程被稱為修剪或分裂的相反過程。

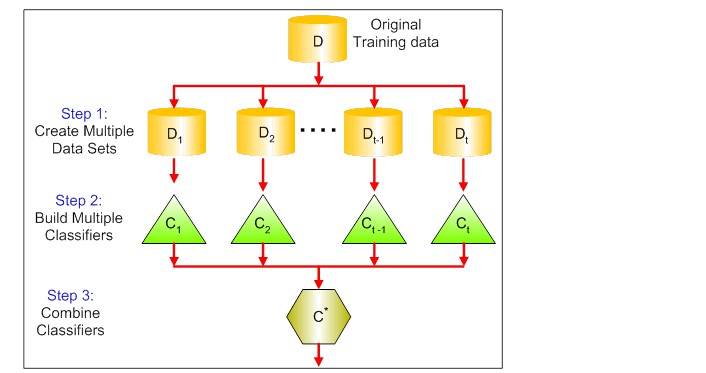

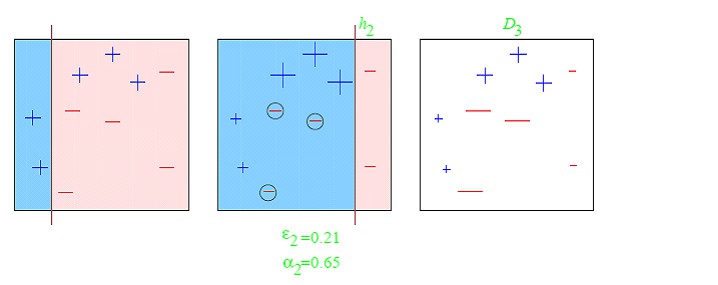

13.什麼是Ensemble學習?

整合是結合不同學習者(單獨模型)的藝術,以便改善模型的穩定性和預測能力。 集合學習有許多型別,但下麵提到的兩種是最受歡迎的整合學習技術。

Bagging

Bagging試圖在小樣本中實現類似的學習者,然後採取所有預測的均值。 在廣義bagging中,您可以針對不同樣本使用不同的學習者。 正如你所期望的那樣,這可以幫助我們減少方差錯誤。

Boosting

Boosting是一種迭代技術,根據後一個分類調整觀察的權重。 如果觀察結果被錯誤地分類,它會試圖增加觀察的權重,反之亦然。 一般而言,提升會減少偏差,並建立強大的預測模型。 但是,他們可能會過度訓練資料。

14.什麼是隨機森林? 它是如何工作的 ?

隨機森林是一種能夠執行回歸和分類任務的多功能機器學習方法。 它也用於縮小維度,處理缺失值,異常值。它是一種集合學習方法,其中一組弱模型組合形成強大的模型。

在隨機森林中,我們種植多棵樹,而不是一棵樹。 要根據屬性對新物件進行分類,每棵樹都會給出一個分類。 森林選擇得票最多的分類(在森林中的所有樹上),並且在回歸的情況下,它取得不同樹輸出結果的平均值。

您有什麼見解,請留言。

原文連結:

https://nitin-panwar.github.io/Top-100-Data-science-interview-questions/

版權宣告:作者保留權利,嚴禁修改,轉載請註明原文連結。

關於更多資料科學內容,請閱讀資料科學系列文章。

資料人網是資料人學習、交流和分享的平臺http://shujuren.org 。專註於從資料中學習到有用知識。

平臺的理念:人人投稿,知識共享;人人分析,洞見驅動;智慧聚合,普惠人人。

您在資料人網平臺,可以1)學習資料知識;2)建立資料部落格;3)認識資料朋友;4)尋找資料工作;5)找到其它與資料相關的乾貨。

我們努力堅持做原創,聚合和分享優質的省時的資料知識!

我們都是資料人,資料是有價值的,堅定不移地實現從資料到商業價值的轉換!

親愛的讀者們,您們有什麼想法,請點選【留言】按鈕,寫下您的留言。

想加入資料人圈子,請新增小編微信:luqin360

點選閱讀原文,進入資料人網,學習資料知識。

公眾號推薦:

360區塊鏈,專註於360度分享區塊鏈內容。

腳印英語,專註於分享實用口語內容。

知識星球

知識星球