作者丨張立石、付程晗、李甲

學校丨北京航空航天大學

研究方向丨計算機視覺

介紹

本文概述了被 2018 年 10 月 ACM Multimedia 會議錄用為 Oral 的論文:Collaborative Annotation of Semantic Objects in Images with Multi-granularity Supervisions。在此論文中,北京航空航天大學碩士研究生張立石、付程晗及其導師李甲,提出了一種基於多粒度監督的影象語意物體協同標註的方法,實現了在幾乎不影響標註精確度的前提下,減少了人工標註的時間。

■ 論文 | Collaborative Annotation of Semantic Objects in Images with Multi-granularity Supervisions

■ 連結 | https://www.paperweekly.site/papers/2218

■ 原始碼 | http://dwz.cn/kltHyMz0

■ 主頁 | http://cvteam.net/

背景

在過去 10 年,大規模影象資料集大大推動了計算機視覺技術的發展。這些資料集中的圖片被一個或多個標簽標註,用於描繪圖片中主要物件的語意類別。在最新的應用,比如自動駕駛,機器人導航,視覺問題回答等,僅有影象級標簽是不夠的,這些應用需要畫素級的語意物件:影象中的物件是什麼、在哪裡。

計算機視覺領域對畫素級標註語意物件的需求越來越強烈,但是畫素級的標註是冗餘乏味的,需要耗費大量的人力資源。因此,為了將現有影象級標簽的資料集轉化為畫素級標註的資料集,在標註精確度不受影響的前提下,減少人工標註時間是很有必要的。

機器和人協同標註的方法已經被研究多年,基於協同策略,現有的方法被分為兩類:Agent-decision 和 Human-decision。

Agent-decision 就是首先標註者進行粗略的標註,然後機器進行自動修正。這些標註結果很少作為 ground-truth。

Human-decision 就是首先讓機器自動生成粗略的標註結果,然後標註者進行手工精細修正,這些標註結果是可以作為 ground-truth。顯然,機器標註結果越好,人工修正的時間越短。但是 Human-decision 方法中缺點就是,機器初始化是靜態的,需要預定義或預先訓練引數,這就意味著會反覆的犯同樣的錯誤即使分割同一個語意物件。

因此,很多協同標註方式都是透過利用機器的參與減少人工標註時間,但是仍然存在一些問題,鑒於此本文提出了一種智慧協同標註工具 Colt:在人機互動標註的過程中不斷學習,使得機器的標註越來越好,人工參與越來越少。

思路

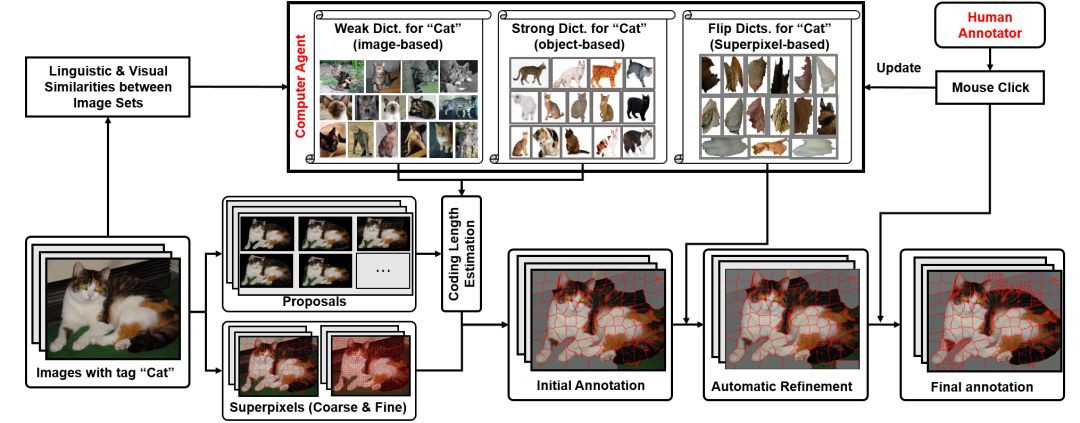

本論文的總體思路是首先利用機器自動生成初始標註結果,人工修正,隨著人工修正的結果越多,機器進行學習可以進行機器自動修正,進一步減少人工修正。整體框架圖如圖 1 所示。

▲ 圖1. 論文整體框架

機器自動化

機器自動化標註主要利用稀疏編碼的思想,對待標註影象進行編碼,編碼長度的大小就意味屬於前景物體的可能性大小,選擇一個閾值分離前背景就能得到自動化標註結果。對於機器初始化標註,作者首先構建了兩個字典:強字典、弱字典,將這兩個字典作為稀疏編碼影象的碼表。

字典構建

首先根據每一類影象的語意標簽計算語意相似性,然後根據影象特徵計算每類影象之間的視覺相似性,聯合得到每類影象之間的總相似性。選擇相似性大於 0.95 的類別作為當前類別的稀疏編碼字典。有畫素級標註影象類別的特徵的作為強字典,沒有畫素級標註影象類別特徵的作為弱字典。

稀疏編碼

編碼物件是用 MCG 演演算法對影象提取出來的排在前 200 的影象 proposal。由於影象的解析度和畫素密度很高,作者為減少人工點選次數,藉助超畫素塊進行操作。作者把 proposal 編碼長度對映到超畫素塊並歸一化得到每個超畫素塊的屬於前景的可能性值,選擇大於 0.4 的作為前景,剩下的作為背景,得到機器初始化結果。

人工修正

根據機器初始化結果,標註者進行修正:如果前後背景錯誤直接點選左鍵,如果邊緣分割錯誤,首先點選右鍵進行分裂成更小的超畫素塊,然後點選左鍵。在人工修正的過程,機器會自動儲存點選超畫素塊的 3 鄰域特徵用於後續的機器自動修正。

機器自動修正

選擇在閾值 0.4 上下 0.15 範圍內的超畫素塊,用人工修正儲存的超畫素塊 3 鄰域特徵進行稀疏編碼,得到這些超畫素塊的編碼長度,歸一化選擇大於 0.95 的超畫素塊進行前景背景在初始化基礎上進行反轉。得到機器自動修正結果。隨著人工標註的結果越多,機器能學的越精確,自動化修正結果會更好。

實驗

本文選取了 40 個影象類別。在 ImageNet 資料集 1000 類中並且和 MSCOCO 有相同標簽的 10 個類別、在 ImageNet 資料集 1000 類中並且和MSCOCO有不同標簽的 10 個類別、不在 ImageNet 資料集 1000 類中並且和 MSCOCO 有相同標簽的 10 個類別,不在 ImageNet 資料集 1000 類中並且和 MSCOCO 有不同標簽的 10個 類別。

作者選擇 10 個年齡在 20-28 周歲之間的標註者進行標註,每個標註者用 LabelMe 進行標註 4 個影象類別。得到 LabelMe 的標註結果,作為本文的 ground-truth。

為了比較作者方法的自動分割結果,作者和當前自動分割處於領先水平的兩個方法:DeepMask 和 SharpMask 進行比較。發現這兩個方法的結果都明顯低於 Colt 的初始化結果。具體結果見圖 2。

▲ 圖2. 自動化對比結果

為了比較最終標註結果,作者選擇另外 10 個年齡在 20-28 之間的標註者用 Colt 進行標註,和 LabelMe 的標註結果計算 F-measure,最終平均結果是 91.21。並比較了 Top5 和 Bottom5,具體結果見圖 3。標註對比結果見圖 4。

▲ 圖3. 最終標註結果

▲ 圖4. 標註對比結果

作者還做了機器自動修正結果對比實驗,發現機器自動修正是有效的,結果見圖 5。

▲ 圖5. 自動修正結果

但是 Colt 還是有一些缺陷,尤其是邊界超畫素分割得不夠好,失敗的標註結果見圖 6 。

▲ 圖6. 失敗結果

總結

與當前能作為 Ground-Truth 的人工標註方法 LabelMe 的標註結果相比,作者標註工具 collaborative tool (Colt) 的標註結果 f-measure 值能夠達到 91.21%,同時作者的標註工具能節約 50% 的人工標註時間。實驗結果表明在兼顧精確度的情況下還能大大的減少標註時間。

點選以下標題檢視更多論文解讀:

#投 稿 通 道#

#投 稿 通 道#

讓你的論文被更多人看到

如何才能讓更多的優質內容以更短路徑到達讀者群體,縮短讀者尋找優質內容的成本呢? 答案就是:你不認識的人。

總有一些你不認識的人,知道你想知道的東西。PaperWeekly 或許可以成為一座橋梁,促使不同背景、不同方向的學者和學術靈感相互碰撞,迸發出更多的可能性。

PaperWeekly 鼓勵高校實驗室或個人,在我們的平臺上分享各類優質內容,可以是最新論文解讀,也可以是學習心得或技術乾貨。我們的目的只有一個,讓知識真正流動起來。

? 來稿標準:

• 稿件確系個人原創作品,來稿需註明作者個人資訊(姓名+學校/工作單位+學歷/職位+研究方向)

• 如果文章並非首發,請在投稿時提醒並附上所有已釋出連結

• PaperWeekly 預設每篇文章都是首發,均會新增“原創”標誌

? 投稿郵箱:

• 投稿郵箱:hr@paperweekly.site

• 所有文章配圖,請單獨在附件中傳送

• 請留下即時聯絡方式(微信或手機),以便我們在編輯釋出時和作者溝通

?

現在,在「知乎」也能找到我們了

進入知乎首頁搜尋「PaperWeekly」

點選「關註」訂閱我們的專欄吧

關於PaperWeekly

PaperWeekly 是一個推薦、解讀、討論、報道人工智慧前沿論文成果的學術平臺。如果你研究或從事 AI 領域,歡迎在公眾號後臺點選「交流群」,小助手將把你帶入 PaperWeekly 的交流群裡。

▽ 點選 | 閱讀原文 | 下載論文 & 原始碼

知識星球

知識星球